Discurso de Michio Kaku

lunes, 30 de abril de 2012

La contaminación

en las ciudades dispara las

posibilidades de padecer

alergias, incluso en población no predispuesta, según acaba de revelar

la Sociedad Catalana de Alergia e Inmunología Clínica (SCAIC) durante la

presentación de los niveles

de polen y esporas de 2011, en la también ha augurado un año "normal"

en cuanto a alergias. Según un estudio epidemiológico europeo, el 21,5 por

ciento de la población española sufre

rinitis alérgica, de los cuales más del 50 por ciento

es alérgico al polen.

Aunque existen pocos estudios científicos sobre la relación entre alergias y contaminación, el presidente de la SCAIC, Antonio Valero, ha explicado que el polen en zonas de gran contaminación como las grandes ciudades "expresa mayor cantidad de proteínas descritas como alergénicas". Concretamente las partículas de emisión diesel pueden ocasionar, en contacto con los granos de polen, el desgrane de la planta, facilitando la llegada de estas partículas a las vías respiratorias. El cambio climático también afecta al calendario polínico de las plantas, ya que avanza o alarga el período de polinización.

Otro dato a tener en cuenta es que los cipreses están este año en polinización "máxima", un hecho que viene provocado por las lluvias "más importantes de lo habitual" en otoño. El platanero de sombra empezará a polinizar - si no bajan las temperaturas hasta menos cero - el 10 de marzo, ya que la temperatura actual recuerda en muchos puntos a la de 2007.

Valero ha manifestado la importancia del diagnóstico precoz, de la elección del fármaco adecuado y deusar gafas de sol para protegerse de los granos de polen. Además ha señalado que desde las 7 hasta las 10 de la mañana se deben evitar los paseos y la ventilación en los domicilios porque es la hora en la que el aire contiene más partículas.

Aunque existen pocos estudios científicos sobre la relación entre alergias y contaminación, el presidente de la SCAIC, Antonio Valero, ha explicado que el polen en zonas de gran contaminación como las grandes ciudades "expresa mayor cantidad de proteínas descritas como alergénicas". Concretamente las partículas de emisión diesel pueden ocasionar, en contacto con los granos de polen, el desgrane de la planta, facilitando la llegada de estas partículas a las vías respiratorias. El cambio climático también afecta al calendario polínico de las plantas, ya que avanza o alarga el período de polinización.

Otro dato a tener en cuenta es que los cipreses están este año en polinización "máxima", un hecho que viene provocado por las lluvias "más importantes de lo habitual" en otoño. El platanero de sombra empezará a polinizar - si no bajan las temperaturas hasta menos cero - el 10 de marzo, ya que la temperatura actual recuerda en muchos puntos a la de 2007.

Valero ha manifestado la importancia del diagnóstico precoz, de la elección del fármaco adecuado y deusar gafas de sol para protegerse de los granos de polen. Además ha señalado que desde las 7 hasta las 10 de la mañana se deben evitar los paseos y la ventilación en los domicilios porque es la hora en la que el aire contiene más partículas.

jueves, 26 de abril de 2012

Logros y retos en la lucha contra la malaria

La Organización Mundial de la Salud (OMS) ha elogiado el progreso que se ha

conseguido en la lucha contra la malaria, aunque ha reclamado la necesidad de

reforzar los mecanismos necesarios para garantizar el acceso universal al

diagnóstico de esta enfermedad.

Coincidiendo con el Día Mundial de la Malaria, la OMS ha presentado su iniciativa 'T3: Test. Tratamiento. Trayectoria', con la que quiere concienciar de la necesidad de diagnosticar los casos de malaria, y tratar con medicamentos específicos para esta enfermedad sólo a las personas afectadas y no a todas aquellas que presentan síntomas.

Richard Cibulskis, miembro del Programa Mundial de Lucha Antipalúdica de la OMS, ha asegurado que actualmente existen herramientas "efectivas y asequibles" para detectar y tratar los casos de malaria, por lo que el objetivo de la nueva iniciativa es que el tratamiento antipalúdico se dé solo a aquellas personas infectadas.

"Antes se trataba con antimaláricos cualquier fiebre. Con esta nueva iniciativa lo que se pretende es que se diagnostiquen los casos de malaria con el test de diagnóstico rápido y sólo se prescriban los fármacos a estos pacientes", ha declarado.

Según la propia OMS, en 2010 se produjeron 216 millones de casos de malaria en el mundo, Y unas 655.000 defunciones, lo que supone una reducción de la mortalidad del 25% con respecto al año 2000; y de un 33% si se miran sólo los datos de África.

Por su parte, Andrea Bosman, especialista también miembro del Programa Antipalúdico de la OMS, ha explicado que los test de diagnóstico rápido "cuestan medio dólar", mientras que el tratamiento para tres días varia entre 30 céntimos de dólar y 1,5 dólares.

Pese a los avances logrados, el secretario general de la ONU, Ban Ki-moon calificó de "tragedia monumental" que todavía hoy más de 1.400 niños mueren cada día en el mundo a causa de la malaria.

"Sigue siendo una tragedia monumental que cada minuto que pasa muera un niño a causa de la malaria, pero podemos ver cierta esperanza en las muchas vidas que se han salvado gracias a las intervenciones internacionales", ha señalado Ban en su mensaje.

El secretario general ha destacado que "más niños están durmiendo seguros con mosquiteras, más familias se están concentrando en habitaciones protegidas de los mosquitos [transmisores de la malaria] y más pacientes reciben las medicinas que necesitan".

Coincidiendo con el Día Mundial de la Malaria, la OMS ha presentado su iniciativa 'T3: Test. Tratamiento. Trayectoria', con la que quiere concienciar de la necesidad de diagnosticar los casos de malaria, y tratar con medicamentos específicos para esta enfermedad sólo a las personas afectadas y no a todas aquellas que presentan síntomas.

Richard Cibulskis, miembro del Programa Mundial de Lucha Antipalúdica de la OMS, ha asegurado que actualmente existen herramientas "efectivas y asequibles" para detectar y tratar los casos de malaria, por lo que el objetivo de la nueva iniciativa es que el tratamiento antipalúdico se dé solo a aquellas personas infectadas.

"Antes se trataba con antimaláricos cualquier fiebre. Con esta nueva iniciativa lo que se pretende es que se diagnostiquen los casos de malaria con el test de diagnóstico rápido y sólo se prescriban los fármacos a estos pacientes", ha declarado.

Focalizar los recursos

A juicio de Cibulskis las nuevas directrices de la OMS ayudarán a "enfocar los pocos recursos allí donde más se necesitan" y contribuirán a alcanzar dos Objetivos de Desarrollo del Milenio: reducir la mortalidad infantil en dos terceras partes y comenzar a reducir la incidencia de la malaria. El objetivo de Naciones Unidas contempla un escenario sin muertes por malaria en el año 2017.Según la propia OMS, en 2010 se produjeron 216 millones de casos de malaria en el mundo, Y unas 655.000 defunciones, lo que supone una reducción de la mortalidad del 25% con respecto al año 2000; y de un 33% si se miran sólo los datos de África.

Por su parte, Andrea Bosman, especialista también miembro del Programa Antipalúdico de la OMS, ha explicado que los test de diagnóstico rápido "cuestan medio dólar", mientras que el tratamiento para tres días varia entre 30 céntimos de dólar y 1,5 dólares.

Pese a los avances logrados, el secretario general de la ONU, Ban Ki-moon calificó de "tragedia monumental" que todavía hoy más de 1.400 niños mueren cada día en el mundo a causa de la malaria.

Una tragedia aún 'inaceptable'

Y aunque la situación ha mejorado con respecto al año pasado, cuando la cifra diaria de menores fallecidos por paludismo superó los 1.900, aún considera "inaceptable" la alta mortalidad a causa de esta enfermedad, responsable del 22% de las muertes infantiles."Sigue siendo una tragedia monumental que cada minuto que pasa muera un niño a causa de la malaria, pero podemos ver cierta esperanza en las muchas vidas que se han salvado gracias a las intervenciones internacionales", ha señalado Ban en su mensaje.

El secretario general ha destacado que "más niños están durmiendo seguros con mosquiteras, más familias se están concentrando en habitaciones protegidas de los mosquitos [transmisores de la malaria] y más pacientes reciben las medicinas que necesitan".

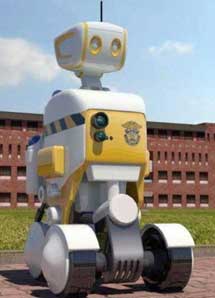

Los reclusos de la prisión surcoreana de Pohang que estuvieran planeando su huída se han encontrado en los últimos días un obstáculo adicional. Se le conoce como RoboGuard, es inmune a las balas o los golpes y ha empezado a patrullar las instalaciones de la cárcel armado con cámaras 3D, altavoces, micrófonos y un sistema informático que le permite alertar a sus colegas humanos de cualquier riesgo para la ley y el orden.

Sus creadores aseguran que garantiza un futuro de seguridad y bajos costes en presidios de todo el mundo.

Los tres primeros modelos de RoboGuard operan ya en la penitenciaría de Pohang, una localidad de medio millón de habitantes situada en la provincia surcoreana de Gyeongsang del Norte. Aunque su versión real no porta armas, el guardia robótico podría haber encontrado su inspiración en 'Robocop', el policía que en la película de Paul Verhoeven lucha contra el crimen en las calles de Detroit.

La habilidad más destacada de los nuevos guardias de Pohang es su capacidad de determinar, mediante el complejo programa que analiza gestos, sonidos y movimientos, el estado de estrés o agresividad de los reclusos a su cargo.

"El primer funcionario de prisiones robótico del mundo", como lo han descrito sus creadores, mide poco más de 150 centímetros y puede ser controlado desde un ordenador o un iPad. También ha sido programado para patrullar de forma autónoma las instalaciones de la cárcel, regresando a su base para recargar la batería cuando sólo le resta un 20%.

El verdadero objetivo del proyecto es rebajar los costes de personal en las prisiones y delegar la vigilancia en robots que pueden permanecer activos las 24 horas del día, sin mostrar agotamiento o bajar la guardia. Los responsables del proyecto han incidido en que en ningún momento esperan que las máquinas entren en contacto con los internos o pongan fin a motines.

Agricultores prehistóricos

Parte de los genes de los actuales habitantes del norte de Europa proceden de

la mezcla de dos comunidades muy diferentes que vivieron en el continente hace

cinco milenios: los cazadores y recolectores primitivos y los agricultores que

viajaron desde el sur hasta colonizar los territorios del norte. Así lo ha

revelado el estudio del ADN de restos de ambas poblaciones, que

se publica esta semana en 'Science'.

La transición hacia una sociedad agrícola de la Humanidad se inició en Oriente Próximo hace unos 11.000 años y tardó otros 5.000 años en llegar a Europa. Estos pioneros agrícolas fueron subiendo desde el sureste hacia el norte, llegando hasta Escandinavia.

Y es allí donde un equipo de investigadores, dirigidos por Pontus Skoglund, de la Universidad de Upsala (Suecia) han encontrado ADN en los restos fosilizados de unos cazadores/recolectores y de granjeros. "Gracias a este material hemos podido demostrar el origen de la variación genética europea, que tiene su origen en la Edad de Piedra, en la inmigración de los agricultores del sur", afirma Anders Götherström, uno de los autores del trabajo.

Hasta ahora, los científicos no habían logrado una respuesta clara a la pregunta de cómo se introdujo la agricultura en Europa, si fue introducida por grupos de nómadas o si se fue extendiendo lentamente. "Nuestro éxito se debe a que accedimos a muy buen material genético, a modernos métodos técnicos y a la experiencia", afirma Götherström.

Conseguir ADN antiguo que no estuviera contaminado con ADN moderno requirió, apuntan, de la tecnología más puntera. El agricultor había sido enterrado debajo de un megalito y se conservaba en buenas condiciones.

"Fue interesante comprobar que ambos grupos, aunque vivían al mismo tiempo y durante más de 1.000 años, tenían unas características genéticas muy distintas", señala Matt Jakobsson, otro de los autores del trabajo, publicado en 'Science'.

La conclusión evidente es que la revolución agrícola fue dirigida por las poblaciones que llegaron desde el sur de Europa, que vivieron en vecindad con los cazadores primitivos, con los que pudieron tener algún cruce puntual, que es lo que explica la diversidad de los europeos actuales. "Hoy nadie tiene el perfil genético de los cazadores/recolectores, pero siguen estando representados en la herencia genética actual de los nórdicos", afirma Skoglund, que diseñó la metodología analítica utilizada.

La transición hacia una sociedad agrícola de la Humanidad se inició en Oriente Próximo hace unos 11.000 años y tardó otros 5.000 años en llegar a Europa. Estos pioneros agrícolas fueron subiendo desde el sureste hacia el norte, llegando hasta Escandinavia.

Y es allí donde un equipo de investigadores, dirigidos por Pontus Skoglund, de la Universidad de Upsala (Suecia) han encontrado ADN en los restos fosilizados de unos cazadores/recolectores y de granjeros. "Gracias a este material hemos podido demostrar el origen de la variación genética europea, que tiene su origen en la Edad de Piedra, en la inmigración de los agricultores del sur", afirma Anders Götherström, uno de los autores del trabajo.

Hasta ahora, los científicos no habían logrado una respuesta clara a la pregunta de cómo se introdujo la agricultura en Europa, si fue introducida por grupos de nómadas o si se fue extendiendo lentamente. "Nuestro éxito se debe a que accedimos a muy buen material genético, a modernos métodos técnicos y a la experiencia", afirma Götherström.

Tecnología puntera

Los investigadores secuenciaron 250 millones de pares de base de ADN a partir de cuatro esqueletos de seres humanos que vivieron en Suecia hace 5.000 años. "Unos pertenecieron a cazadores/recolectores y otros a agricultores, que vivían a menos de 400 kilómetros de distancia. Después comparamos sus datos con poblaciones modernas y encontramos que los finlandeses son más similares a los cazadores/recolectores y los granjeros a los pueblos mediterráneos", apunta Skoglund.Conseguir ADN antiguo que no estuviera contaminado con ADN moderno requirió, apuntan, de la tecnología más puntera. El agricultor había sido enterrado debajo de un megalito y se conservaba en buenas condiciones.

"Fue interesante comprobar que ambos grupos, aunque vivían al mismo tiempo y durante más de 1.000 años, tenían unas características genéticas muy distintas", señala Matt Jakobsson, otro de los autores del trabajo, publicado en 'Science'.

La conclusión evidente es que la revolución agrícola fue dirigida por las poblaciones que llegaron desde el sur de Europa, que vivieron en vecindad con los cazadores primitivos, con los que pudieron tener algún cruce puntual, que es lo que explica la diversidad de los europeos actuales. "Hoy nadie tiene el perfil genético de los cazadores/recolectores, pero siguen estando representados en la herencia genética actual de los nórdicos", afirma Skoglund, que diseñó la metodología analítica utilizada.

domingo, 15 de abril de 2012

El misterio de las neuronas

Las neuronas de tu sistema nervioso no solo son incapaces de dividirse para dar lugar a nuevas células –como ocurre con otros tejidos del cuerpo– sino que se mueren de manera incesante a lo largo de la vida. Se ha calculado que esta muerte se produce a razón de una neurona por segundo, de manera que desde que comenzaste a leer este párrafo tienes unas 10 neuronas menos.

Un número inmenso de neuronas

En primer lugar, el hecho de que pierdas una neurona por segundo no es gran cosa si lo comparas con el número de ellas que trae de serie tu sistema nervioso. Es más, calcular todas las neuronas que pierde de manera natural una persona a lo largo de la vida es un ejercicio excelente para comprender la enorme cantidad de células que tenemos ahí dentro. Trabajar con números muy grandes resulta poco natural para la mente humana, ya que no está preparada para imaginar lo que son miles, millones y miles de millones.

Nuestros ancestros podían salir de caza y traer para la cena un par de ciervos, pero ninguno tenía una despensa tan grande como para llegar por la noche cargado con 86.000 millones de ciervos, ni siquiera de castañas. Ese es el número de neuronas que tienes en el encéfalo. ¿Puedes imaginar lo que significa esa cifra?

Podemos hacernos una idea de lo grande que es ese número con el ejercicio que antes comentaba: calcular las que pierde una persona a lo largo de, por ejemplo, 85 años de vida; es decir, calcular los segundos que ha vivido al alcanzar esa edad. Una vez multiplicados años, días, horas, minutos y segundos nos sale esta cifra: 2 680 560 000. Ya ves, entre 2 000 y 3 000 millones de neuronas que se pierden a lo largo de una vida. ¡Pero tenemos 86 000 millones! El número es tan grande que, incluso perdiendo una por segundo, al cabo de 85 años todavía queda ¡el 96,9 % del total!

La memoria y el “yo” requieren estabilidad

Bueno, ya hemos solucionado un problema: ha dejado de preocuparnos el que las neuronas se nos mueran de forma incesante. Pero todavía nos falta encontrar algún sentido evolutivo al hecho de que las neuronas no se dividan para dar lugar a células nuevas. Incluso teniendo muchas, nunca está de más que el tejido tenga la capacidad de regenerarse con rapidez en el caso de algún tipo de lesión o para aumentar las capacidades cognitivas si fuera necesario; al fin y al cabo las células de otros tejidos del cuerpo humano se dividen sin ningún problema. Pero hay al menos una razón, una poderosa razón: tu identidad.

Tu mente consciente, tu “yo”, es el resultado de la arquitectura y la actividad del encéfalo. Todos los días, cuando te despiertas por la mañana, vuelves a ser la misma persona del día anterior. Para que esto sea así es necesario que se mantenga de alguna manera la memoria. Sin memoria no existes, desapareces y te reinventas a cada instante. La manera que tiene nuestro sistema nervioso de mantener una memoria y un “yo” a lo largo del tiempo es manteniendo la organización arquitectónica y funcional de la estructura que los sustenta, es decir, manteniendo la estructura de tu encéfalo. Para ello es preciso que las neuronas y sus conexiones tengan una cierta constancia, que se mantengan en el tiempo. Si las neuronas del encéfalo tuviesen un recambio constante como ocurre con otros tejidos sería muy difícil o imposible mantener estable el llamado “yo” autobiográfico.

El proceso evolutivo ha sacrificado la capacidad de división de las neuronas de tu encéfalo para mantener una mente con memoria, algo que supuestamente tiene sus ventajas a la hora de moverse por el mundo. Es importante tener en cuenta que la formación de la memoria requiere al mismo tiempo una cierta plasticidad, precisamente para la formación de nuevos recuerdos, para la modificación de los existentes y, también, para la pérdida de muchos otros. Esa plasticidad se consigue modificando la cantidad y la función de las sinapsis, esos lugares de interacción entre neuronas. Se trata por lo tanto de un sistema estable pero con una cierta capacidad de modificación.

Evolución y autorregeneración

Parece que todo cuadra. Pero todavía nos queda un cabo sin atar, algo que requiere una explicación: se trata del crecimiento de prolongaciones a partir de una célula ya existente. Los axones –las prolongaciones que usan las neuronas para enviar sus mensajes eléctricos– del sistema nervioso periférico pueden regenerar sus terminaciones tras una lesión y volver a funcionar correctamente. No cabe duda de que es una función útil, que se pone en marcha, por ejemplo, cada vez que dañas las terminaciones sensoriales de la superficie de la piel. Sin embargo, ante un daño en sus axones, las neuronas del sistema nervioso central –las que tienes en tu encéfalo y médula espinal– son incapaces de regenerar correctamente sus conexiones y volver a reorganizarse, lo cual sería muy útil en caso de una lesión medular o en accidentes o enfermedades que afecten al encéfalo. ¿Hay algo que explique esta diferencia? Sí, y para ello cedo la palabra a un gran neurocientífico, Manuel Nieto Sampedro, experto en plasticidad neural:

En el sistema nervioso periférico “los individuos lesionados tienen tiempo y oportunidad de reproducirse y, por ello, el proceso evolutivo ha podido seleccionar y conservar mecanismos de plasticidad neural que permiten la reparación de lesiones”. Sin embargo la cosa cambia en el sistema nervioso central (SNC), ya que en este caso las lesiones de una cierta intensidad “impiden la vida normal y si, caso improbable, el individuo lesionado sobrevive, su posibilidad de reproducirse es prácticamente nula. Así, las posibles mutaciones conducentes a una reparación efectiva de lesiones en el SNC no tienen posibilidad de seleccionarse y ser conservadas. De ahí que la reparación espontánea de lesiones en el SNC de los mamíferos no ocurra”.

Neuronas recién nacidas

Con todo, desde hace unos años sabemos que existe una cierta capacidad de generación de neuronas nuevas en el SNC. El hecho de que las neuronas no se dividan no es incompatible con la posibilidad de que, de manera controlada y limitada, se incorporen neuronas nuevas al sistema nervioso adulto mediante su formación a partir de células troncales: a esto se le llama neurogénesis.

La existencia de neurogénesis en el SNC de los seres humanos es un importante tema de investigación y debate en la neurociencia actual. En los últimos años se ha descubierto que, efectivamente, todos tenemos células troncales en nuestro encéfalo que pueden originar neuronas nuevas. Todavía no se sabe el alcance y las funciones de este proceso de neurogénesis, pero en algunas regiones del encéfalo, como en la corteza olfativa o el hipocampo, parece que ocurre de manera constante. Según esto, hay zonas encefálicas que reciben a lo largo de la vida un aporte regular de neuronas que sustituyen a otras que van muriendo. Todo apunta a que este proceso es muy limitado y compatible con la estabilidad estructural que he comentado más arriba. El descubrimiento de neurogénesis en el SNC adulto abre una nueva puerta a la investigación de terapias que permitan la reparación controlada en caso de lesiones o enfermedades neurodegenerativas.

Conclusión

A modo de resumen, esta es pues la situación: las neuronas de tu SNC se mueren poco a poco, pero tienes tantas que la cosa no es preocupante. En caso de necesitar una reserva extra de neuronas, hay un pequeño problema, ya que esas células no se dividen; son los costes de mantener la integridad estructural y funcional del sistema. Aún así, hay dos procesos de regeneración en marcha: los axones de las neuronas periféricas pueden restaurar sus conexiones tras una lesión y, por otra parte, en algunas regiones del SNC se han constatado procesos de neurogénesis que dan lugar al nacimiento constante de un limitado número de neuronas a lo largo de toda la vida.

¿Cómo aterrizamos en Marte?

Explicación gráfica de cómo se pude poner un satélite en la superficie de Marte

La pelicula Titanic de James Cameron , por fin tendrá un cielo correcto

De cómo Neil deGrasse Tyson consiguió poner el cielo correcto en la película Titanic

El hundimiento del titanic (4ªparte)

Degradación

Al final, en un siglo o dos, el Titanic volverá a su estado natural, el de menor energía: un depósito de mineral de hierro. Esto no es nada glamuroso y algunos lo considerarán como una enorme tragedia, pero es no es así como lo ven una investigadora y un ingeniero. Es simplemente cuestión de química y gravedad.

Jennifer Hooper McCarty y Tim Foecke en What Really Sank the Titanic

Cuando Robert Ballard exploró el trasatlántico en 1986 no encontró ningún resto humano salvo botas y zapatos, en cuyo curtido se emplearon taninos que los hacen resistentes frente a la putrefacción y el ataque de bacterias. Se han hecho cálculos sobre la velocidad de descomposición que sugieren que cualquier cadáver que quedara en el Titanic habría desaparecido completamente unos 30 años después de su hundimiento.

El casco del buque ofrece refugio a varias especies de peces abisales como el pez cola de rata e invertebrados como crustáceos, crustáceos, esponjas, cohombros, corales, ofiuras y crinoideos y, además, es pasto de la corrosión.

Aunque la corrosión se manifiesta en el Titanic en dos formas, corrosión electroquímica y corrosión biológica, de la segunda es de la que se ha oído hablar más en forma de «bacterias que devoran el acero del Titanic generando ríos de corrosión».

En su forma más básica, la corrosión es un proceso electroquímico por el cual los átomos de hierro transfieren electrones al oxígeno, combinándose entre sí para formar óxido férrico, lo que se conoce comúnmente como óxido o herrumbre. Este proceso se ve favorecido en agua salada porque la sal (cloruro sódico) aumenta la conductividad del agua, permitiendo que haya una circulación de electrones (corriente eléctrica) que acelera el proceso de oxidación. La oxidación también se ve favorecida cuando se deforma el metal debido a que se crean defectos en su estructura cristalina.

El Titanic no está formado únicamente de acero; también tiene otros metales como el cobre, el bronce o el latón (aleaciones de cobre con estaño o zinc, respectivamente). El hierro y el zinc tienen una gran tendencia a ceder electrones (oxidarse) frente a metales como el cobre o el estaño, que tienen tendencia a ganarlos. En presencia de un conductor de electrones como el agua salada, estamos ante otro tipo de corrosión: la corrosión galvánica.

Las formaciones más llamativas de la corrosión del Titanic son las oxidolactitas, carámbanos de óxido con aspecto de agujas que pueden alcanzar varios metros de longitud. Las oxidolactitas forman estructuras anulares porosas, de color marrón rojizo, llenas de canales y espacios por los que puede circular el agua. Los compuestos de hierro en forma de óxidos, carbonatos e hidróxidos (goethita o lepidocrocita) pueden constituir hasta el 35% de su masa; el resto lo forman comunidades de microorganismos como hongos, bacterias del hierro, bacterias reductoras de sulfato, bacterias heterotrópicas aerobias, bacterias desnitrificantes y arqueobacterias. Se estima que al día se convierten en óxido entre 270 y 450 kilos de acero. De hecho, el Titanic se encuentra en una zona con unos altos niveles de oxígeno y salinidad para lo que es la media a esa profundidad que favorecen el proceso.

Aunque se han identificado 27 tipos de bacterias, sólo una ha sido completamente caracterizada: Halomonas titanicae, la «mónada tolerante a la sal del Titanic», aislada por un grupo de investigadores del Departamento de Microbiología y Parasitología de la Universidad de Sevilla, el Centro de Ciencia de Ontario, en Toronto, y el Departamento de Ingeniería Civil de la Universidad de Dalhouse, en Halifax.

Basándose en el ritmo de degradación de la proa, se estima que desaparecerá consumida por la corrosión dentro de entre 280 y 420 años. En la popa, más deteriorada, la velocidad de corrosión va unos 40 años por delante.

Hipotermia

Golpear el agua fue como si un millar de cuchillos se clavaran en el cuerpo y no es de extrañar, dado que la temperatura del agua era de dos grados bajo cero o dos grados por debajo de su punto de congelación.

Charles H. Lightoller en Titanic and other Ships

Los lamentos cesaron por completo hacia las tres de la madrugada, unos cuarenta minutos después del hundimiento. El quinto oficial Lowe, que había distribuido los pasajeros de su bote salvavidas entre otros para regresar a buscar supervivientes, tan sólo consiguió rescatar a tres personas con vida.

El cuerpo humano pierde calor unas 25 veces más rápido en agua que en el aire a esa misma temperatura. El equilibrio térmico, es decir, cuando no hay ganancia ni pérdida de calor, se da en el aire alrededor de los 21 °C y en el agua a 33 °C. A la temperatura a la que estaba el agua cuando se hundió el Titanic (unos dos grados bajo cero), el cuerpo trataría al principio de generar más calor tiritando, pero no sería suficiente para contrarrestar el enfriamiento. Al descender la temperatura del cuerpo por debajo de los 35 °C, empezarían a manifestarse los primeros síntomas como dificultad para hablar y entorpecimiento de los movimientos. A los 15 minutos se produciría la pérdida de consciencia y la muerte sobrevendría a los 45 minutos.

Tratar de nadar empeoraría la hipotermia al perder calor más rápidamente. Lo mismo ocurre tomando bebidas alcohólicas. Como vasodilatador, el alcohol hace que aumente el riego sanguíneo en la piel y las extremidades, con lo que se tiene una sensación momentánea de calor que, en realidad, lo que hace es aumentar su pérdida.

El hundimiento del titanic (3ªparte)

Descubrimiento y exploración

Cuando empecé a pensar en emprender la búsqueda del Titanic, en realidad creí que era sólo una medida para conseguir otro fin. Pensé que todo el elemento mágico que giraba en torno del buque perdido me ayudaría a conseguir el dinero necesario para dar un gran paso en la tecnología de la investigación submarina. Pero la idea de llegar al legendario barco hundido llegó a convertirse en una obsesión.

Robert Ballard en El descubrimiento del Titanic

Dos años después, el Argo estaba listo y Jason era todavía un proyecto. El Argo era un vehículo de arrastre submarino de dos toneladas, 4,5 metros de largo, 1 metro de altura y 1 metro de ancho equipado con cámaras de vídeo y remolcado por un cable desde el barco nodriza. El prototipo de Jason, Jason Junior, era un vehículo operado por control remoto (ROV, remotely operated vehicle), que contaba con su propio sistema de propulsión y cámaras de vídeo. Su pequeño tamaño le permitía ir enganchado a un sumergible tripulado y explorar lugares a los que no podían llegar los submarinos convencionales.

El plan inicial era que el equipo francés localizara el Titanic con el sonar para que luego el equipo estadounidense filmara los restos en vídeo con Argo tomara fotografías con el ANGUS (Acoustically Navigated Geological Underwater Survey, observación geológica submarina por navegación acústica). Los franceses habían estado buscando durante dos meses sin ningún resultado, así que la estrategia cambió con la llegada de Ballard. Explorando los restos del USS Thresher y el USS Scorpion, había comprobado que los objetos pesados en un naufragio suelen caer casi directamente por debajo del lugar en el que se hundieron, mientras que los objetos ligeros lo hacen con más lentitud y son arrastrados por las corrientes marinas dejando un rastro que lleva hasta los restos más pesados.

Ballard sospechaba que el Titanic se había partido en dos y que había dejado un rastro de escombros mientras se hundía, por lo que buscarían esos restos usando el Argo. Pasada la medianoche del 1 de septiembre de 1985, el Argo descubrió una de la cinco calderas simples del Titanic (se desprendieron cuando el barco se partió) y pocas horas después, la sección de proa.

En julio de 1986, Jason Junior exploró el interior del barco y demostró la eficacia de un robot equipado con un sistema de cámaras de video y controlado con la ayuda de un cable de fibra óptica de 100 metros de longitud. La primera versión de Jason apareció en 1988 y en 2002 se desarrolló su segunda generación. Por desgracia, Jason Junior se perdió en 1991 en el Océano Pacífico.

Argo y Jason Junior fueron los primeros de una serie de vehículos submarinos que han explorado los restos del trasatlánticos durante 25 años, algunos de los cuales han sido desarrollados con financiación privada.

La última expedición hasta ahora se realizó durante los meses de agosto y septiembre de 2010. Liderada por RMS Titanic, Inc., la Institución Oceanográfica de Woods Hole y el Instituto Waitt, ha sido la que ha empleado la tecnología más avanzada para cartografiar los restos, obtener una imagen tridimensional de lugar del naufragio y estudiar los efectos de la corrosión.

En la primera fase de la expedición, realizada entre el 25 y el 29 de agosto, se emplearon dos vehículos submarinos autónomos REMUS 6000 equipados con varios sistemas de sonar para hacer un mapa preliminar de los restos que ocupó un área de 4,8 kilómetros de ancho por 8 kilómetros de largo.

Veinticinco años después de su descubrimiento, la tecnología ha permitido ver el Titanic y su campo de restos como realmente se encuentran en el fondo marino a 3800 metros de profundidad. El lugar en el que yace el Titanic es, con diferencia, la zona del fondo marino abisal mejor estudiada.

Del mismo modo que Robert Ballard, James Cameron también quedó atrapado por la fascinación que ejerce el trasatlántico de la White Star hasta el punto de llegar a afirmar que hizo la película Titanic para poder filmar sus restos; más adelante volvió al naufragio para probar nuevos equipos de filmación y nuevos modelos de ROV. Como pionero del nuevo cine en 3D, James Cameron desarrolló gran parte de la tecnología a partir de Ghosts of the Abyss (2003), un documental en 3D para IMAX en el que regresaba al Titanic con Bill Paxton.

El hundimiento del titanic (2ªparte)

Última noche del Titanic

Por supuesto, ahora conocemos la extraordinaria combinación de circunstancias que se dieron en aquel momento y que sólo se producen una vez cada cien años; que todas ellas se dieran precisamente en esa noche en concreto demuestra, desde luego, que todo estaba en nuestra contra.

Charles H. Lightoller, segundo oficial del Titanic

Se asumía que en una noche clara y sin luna, podrían detectarse a una distancia entre 1,5 y 5 kilómetros como una masa blanca u oscura que presenta un anillo brillante en su base por la espuma que se forma al romper las olas, pero en la noche en la que el Titanic chocó con el iceberg el mar estaba en calma y lo único que habían detectado los vigías era una especie de «bruma» en el horizonte.

Estudiando los registros meteorológicos de la zona y los testimonios de los supervivientes, el historiador británico Tim Maltin sostiene que fue una ilusión óptica lo que provocó que el vigía Frederick Fleet se percatara del iceberg cuando era demasiado tarde y que el Californian, el barco que aparentemente estaba más cerca del Titanic cuando se hundió, malinterpretara las señales de auxilio.

En su viaje a Nueva York, el Titanic estaba abandonando la corriente cálida del Golfo para entrar en la corriente fría del Labrador, responsable también de arrastrar los icebergs que se desprenden desde los glaciares de Groenlandia.

En la noche de su hundimiento, el trasatlántico se encontraba en los límites entre ambas corrientes, donde se había producido una inversión térmica: las masas de aire enfriado por la corriente del Labrador permanecían por debajo de las masas de aire calentadas por la corriente del Golfo y las altas presiones mantenían el aire libre de niebla.

El Titanic se enfilaba hacia el él a 22,5 nudos (unos 41,67 km/h). La tripulación tenía algo más de un minuto para reaccionar.

En ese momento, Fleet hizo sonar tres veces la campana indicando que había un objeto delante y llamó por teléfono al puente advirtiendo que había un iceberg al frente. El primer oficial William M. Murdoch, de guardia en el puente, dio la orden de virar para esquivar el iceberg y el giro redujo algo la velocidad debido a la resistencia hidrodinámica, por lo que se estima que el Titanic iba a unos 20,7 nudos (38,3 km/h) en el momento del choque.

Murdoch primero ordenó girar a todo babor para evitar que la proa encarara el iceberg mientras mandaba parar los motores y, posiblemente, dar marcha atrás en un intento de minimizar el daño; sin embargo, las máquinas no se pararon completamente o dieron marcha atrás hasta un minuto o dos después de la colisión, con lo que esta acción apenas tuvo repercusión.

El giro habría expuesto peligrosamente todo el costado de estribor, por lo que cuando el iceberg pasó por el puente, ordenó virar a todo estribor. Si bien la segunda parte de esta maniobra en «S» consiguió que la popa se alejara del iceberg, la primera no se realizó a tiempo para evitar la colisión.

Aunque aparentemente el impacto del iceberg fue suave, el daño causado fue letal: en los aproximadamente siete segundos que estuvo en contacto, el iceberg provocó daños que se extendieron a lo largo de seis compartimentos estancos, desde la bodega de proa hasta la carbonera de la sala de calderas número 5.

Habiendo brechas en estos compartimentos estancos, el agua acabaría por llenarlos y por pasar a los demás hacia la popa con lo cual el Titanicse iría a pique se hiciera lo que se hiciera.

Su hundimiento era una certeza matemática.

Hundimiento del Titanic

Mi estimación para el tamaño de la brecha (y considerando algunos obstáculos debidos a la presencia de las cubiertas y otros elementos), es que la superficie total a través de la cual penetró el agua en el barco fue de unos 1,11 metros cuadrados. La extensión del daño a proa y popa, es decir, desde la perforación del extremo anterior hasta la perforación del extremo posterior, en la carbonera situada en la parte delantera de la sala de calderas número 5, fue de unos 61 metros y la anchura media de una brecha de esas dimensiones fue de sólo unos 19 milímetros. Esa es la razón por la que he manifestado esta mañana que creía que el daño tenía que haberse concentrado en determinados lugares; en otras palabras, que no era una brecha continua. Una brecha de 19 milímetros de ancho y 61 metros de largo no me parece que dé cuenta del posible daño, aunque debería de haber sido esa magnitud en promedio.

Edward Wilding, ingeniero naval de Harland & Wolff

Aunque finalmente se consideró que había producido una grieta continua de 90 metros, en la comisión británica que investigó las causas del hundimiento, el ingeniero naval de Harland & Wolff Edward Wilding apuntó la posibilidad de que se hubiera tratado de un daño pequeño e intermitente basándose en el patrón de inundación de cada compartimento según lo habían descrito los supervivientes. Dado que los compartimentos se habían inundado de forma desigual, dedujo que cada uno de ellos había sufrido su propio daño.

De haber abierto el iceberg una brecha de 90 metros, tendría que haber tenido un grosor de unos dos centímetros para haber dado cuenta del ritmo de inundación y si se hubiera producido la brecha tradicionalmente asumida, el barco se habría hundido en cuestión de minutos en lugar de dos horas y cuarenta minutos.

Sin embargo, los cálculos de Wilding se olvidaron. Aunque gran parte del daño causado por el iceberg se encontraba oculto bajo casi 17 metros de sedimentos marinos, cuando Robert Ballard exploró los restos del Titanicen 1986 observó que en una zona del costado de estribor, donde estaba la sala de calderas número 6, los remaches habían saltado y las placas se habían separado y lo interpretó como parte del daño provocado por el iceberg.

Matthias identificó lo que parecían seis fisuras a lo largo de la unión entre las planchas de costado de estribor que se extendían a lo largo de unos 76 metros, desde la bodega de proa hasta la carbonera de la sala de calderas número 5, y que afectaba a seis compartimentos estancos. Esto parecía corresponderse con las fisuras provocada por el iceberg según los testimonios y los cálculos de Wilding.

La parte que no se suele contar es que Mathias también detectó grietas similares en el costado de babor, por lo que los daños podrían haber sido provocados cuando la proa impactó contra el fondo. Aun así, el área calculada del daño (1,05 metros cuadrados) se acerca bastante a la estimación de Wilding (1,11 metros cuadrados).

La última fisura (F), de unos 13,7 metros, selló el destino del Titanic y afectó a la sala de calderas número 6, en el quinto compartimento estanco, penetrando entre 0,5 y 1,5 metros en la carbonera de sala de calderas número 5.

El cuadro general que se tiene del hundimiento del Titanic es que al chocar con el iceberg, la presión del hielo provocó que reventaran los remaches que mantenían unidas las planchas de acero creando una serie de huecos por donde penetró el agua y que el barco se partió antes de hundirse debido a que el acero del casco no pudo soportar la tensión estructural. Si bien los modelos sobre el hundimiento coinciden en estos puntos, difieren en detalles como el ángulo en el que se partió el barco (con un ángulo bajo entre 11 y 17 grados o ángulo alto superior a 30 grados), la dirección y localización de la fractura (desde las cubiertas superiores hasta la quilla o desde la quilla hasta las cubiertas superiores y por delante o por detrás de la tercera chimenea), si la rotura se produjo en la superficie o bajo el agua, el número de fragmentos que generó la rotura y la explicación de los daños sufridos por la sección de popa.

El hundimiento del titanic (1ªparte)

Construcción

Al construir el Titanic, mis socios y yo confiábamos en crear un buque que no fuera destruido por las amenazas del mar o los riesgos de la navegación. Los hechos han demostrado la inutilidad de esa esperanza.

J. Bruce Ismay en declaraciones a The Lewiston Daily Sun el 22 de abril de 1912

Aunque la White Star hacía tiempo que había abandonado la velocidad por la comodidad, los buques de la clase Olympic serían lo suficientemente rápidos para que la travesía entre Southampton y Nueva York se realizara en unos siete días, un par de días más de lo que tardaban sus rivales de la Cunard.

La construcción del Titanic se produjo en un período de transición entre el uso de acero y el de hierro forjado en la construcción naval, por lo que ambos materiales se emplearon en su casco. Aunque el hierro forjado fue el primer material empleado en los barcos de vapor modernos, la producción industrial de acero lo fue relegando rápidamente a un segundo plano.

El acero dulce era el tipo más empleado de acero para la construcción de los buques de la época. Al tener un contenido en carbono que no supera el 0,25%, era ideal para darle forma al no ser ni demasiado frágil ni demasiado maleable, pero su principal inconveniente era su tendencia a la corrosión, por lo que había que pintarlo con frecuencia y necesitaba un cierto grado de mantenimiento.

La introducción de los procesos de Bessemer y de Siemens-Martin (horno de solera abierta) en los años 50 y 60 del siglo XIX permitió producir acero barato y a gran escala, aunque los astilleros Harland & Wolff optaron por el acero fabricado según el proceso de Siemens-Martin, más lento y laborioso, aunque permitía comprobar constantemente las propiedades del acero y podía generar una mayor variedad de tipos.

En el casco Titanic se emplearon unas 2000 planchas de acero de un tamaño medio de unos 9 metros de largo por 1,8 metros de ancho; las más grandes podían alcanzar casi 11 metros de largo y pesaban 4250 kilos. El espesor típico de las placas era de 2,5 centímetros, aunque variaba entre 1,5 y 3,8 centímetros dependiendo de las zonas. Antes de la invención de la soldadura, las placas metálicas se unían mediante remaches.

El principio es bastante simple: el remache, calentado al rojo vivo, se introduce en unos agujeros entre las placas y se golpea uno de sus extremos hasta que adquiere una forma aplanada o de seta. Al enfriarse, el remache se contrae y tira de las placas uniéndolas firmemente.

En el Titanic se emplearon remaches de acero dulce y de hierro forjado. Los primeros se colocaron mediante remachadoras hidráulicas en un 60% del casco, en la zona media donde se consideraba que se darían las mayores tensiones y las placas estaban unidas entre sí por tres o cuatro filas de remaches. Los de hierro forjado los coloraron manualmente cuadrillas de remachadores en el restante 40%, en las secciones de proa y popa, demasiado estrechas para las voluminosas remachadoras de la época, y las planchas estaban unidas mediante una doble fila de remaches.

Mientras el remachado hidráulico proporcionaba un acabado superior y homogéneo, el remachado manual era más heterogéneo y dependía bastante de la pericia de la cuadrilla que colocaba los remaches. Una forma de comprobar si los remaches habían sido bien colocados era golpearlos con un martillo; un tintineo indicaba que habían sido bien puestos, mientras que un sonido sordo indicaba lo contrario. En total, se emplearon tres millones de remaches en todo el barco.

La seguridad durante la travesía la proporcionaban dos sistemas: un doble fondo y un sistema de compartimentos estancos. El doble fondo del casco tenía 1,6 metros de espesor y llegaba a los 1,9 metros en la sala de máquinas para proporcionar un soporte adicional a los motores. Aparte de la protección frente a encallamientos, en el doble fondo se almacenaba el lastre para regular la flotabilidad y el agua para las calderas.

Los compartimentos estancos de la clase Olympic fueron bastante publicitados en la época, aunque su uso como sistema de seguridad no era nuevo. Uno de los primeros buques en incorporarlos fue el Great Eastern en 1858. Aunque este trasatlántico mixto de vapor y velas fue un fracaso comercial, su doble casco de hierro forjado y el uso de compartimentos estancos supusieron una gran innovación técnica en su tiempo.

Con el dilema siempre presente entre seguridad y beneficios, las navieras abandonaron el uso del doble casco y dejaron únicamente el doble fondo y los compartimentos estancos como sistema de seguridad.

Después del naufragio del Titanic, volvió a introducirse el doble casco y en la actualidad se recomienda su uso en buques de pasajeros, buques cisterna, petroleros y submarinos. Lo que hacía únicos a los compartimentos estancos de los buques de la clase Olympic es que disponían de un sistema de puertas estancas cuyo cierre se podía controlar automáticamente desde el puente.

La descripción del mecanismo decía que (las negritas son mías):

Cada puerta se mantiene abierta mediante un embrague de fricción que puede liberarse instantáneamente con un potente electroimán controlado desde el puente de forma que, en caso de accidente o en cualquier circunstancia que así lo requiera, el capitán puede, mediante el simple accionamiento de un interruptor eléctrico, cerrar en un momento todas las puertas y hacer el buque prácticamente insumergible.

Otros trasatlánticos como el Lusitania tenían un sistema de compartimentos estancos longitudinales en vez de transversales, similar a la de los buques de guerra de la época. Esto creaba una especie de doble casco que, en teoría, proporcionaba una mayor protección pero que multiplicaba considerablemente el riesgo de que el barco escorara demasiado y zozobrara si tenía una vía de agua. Cuando fue torpedeado por un submarino alemán el 7 de mayo de 1915, el Lusitania se hundió en 18 minutos y la excesiva escora a estribor que provocó la vía de agua impidió arriar los botes salvavidas del costado de babor.

Un punto muy a tener en cuenta es que, aunque el Titanic se construyó con las últimas técnicas de construcción naval y los sistemas de seguridad más avanzados, su diseño no era revolucionario en sus elementos básicos si se compara con otros buques de pasajeros de la época (por ejemplo, en la construcción del Lusitania se emplearon únicamente remaches de acero) y la forma del casco y el timón era bastante convencional y estaba basada en la de otros barcos de la White Star pero a escala más grande.

¿Acero frágil o remaches débiles?

Los resultados mostraron que la temperatura de transición dúctil-frágil, es decir, la temperatura en la que un material deja de ser maleable para volverse frágil estaba por encima de los 0 °C.

Este dato lo acompañaron con un análisis de la composición del acero del Titanic que indicaba que los niveles de azufre y fósforo eran superiores a los del acero moderno, sugiriendo que alguno de estos elementos podían haber contribuido a hacerlo más frágil.

El tratamiento mediático de este descubrimiento contribuyó a extender la «teoría del acero frágil»: el acero del Titanic era de mala calidad y debido a la baja temperatura del agua, las planchas se rompieron cuando el iceberg las presionó.

Cinco años más tarde, en otra serie de ensayos Charpy realizados a temperaturas entre -55 y 179 °C por un grupo de la Universidad de Missouri-Rolla con dos muestras de acero del Titanic recuperadas en la expedición de 1996 y comparándolas con una muestra de acero moderno ASTM A36, determinaron que la temperatura de transición del acero del Titanic era de unos 40 °C, mientras que la del acero A36 era de -27 °C; en otras palabras, no hacía falta agua helada: el acero del Titanicse volvía frágil a la temperatura de un típico día de verano.

La proporción de oxígeno indicaba que se trataba de acero semicalmado y los niveles de nitrógeno confirmaron que se había fabricado por el proceso Siemens-Martin. Nada nuevo para el acero que se fabricaba en 1911.

Antes de entrar en más detalles, conviene explicar brevemente cómo es la estructura del acero. Visto a través del microscopio, el acero aparece como un material granular formado por granos de ferrita (regiones oscuras formada por cristales de hierro) y colonias de perlitas (regiones más claras formadas por ferrita y carburo de hierro dispuestos en capas).

Pues bien, el acero del Titanic tenía granos de ferrita de tamaño superior al del acero A36 (el tamaño del grano aumenta la temperatura de transición), a lo que hay que añadir una baja proporción manganeso:azufre (o lo que es lo mismo, un mayor contenido de azufre) y un elevado contenido de fósforo, factores que contribuyen a la fragilidad del acero. El azufre y el fósforo tienden a reaccionar con el hierro formando compuestos que se acumulan en los límites de los granos de ferrita, debilitando las uniones entre ellos y aumentando la probabilidad de fractura por esas zonas.

La proporción manganeso:azufre es un parámetro importante debido a que el azufre tiene más afinidad por el manganeso que por el hierro, lo que elimina la amenaza de que los átomos de azufre debiliten la estructura del acero. Aunque los resultados del grupo de la Universidad de Missouri-Rolla confirmaron en cierta medida los del equipo de DREA/CANMET, eso no significaba que la calidad del acero del Titanicfuera inferior; sus propiedades mecánicas se encontraban dentro de las especificaciones de diseño de 1911, aunque según la normativa actual no sería apropiado como material de construcción en condiciones de bajas temperaturas.

También había otros factores a tener en cuenta:

- El Olympic tenía el mismo diseño que el Titanic, fue construido en el mismo astillero con los mismos materiales y permaneció en servicio durante 24 años. Entre ambos, sólo había un iceberg de diferencia.

- A juzgar por los testimonios de algunos pasajeros y tripulantes, el impacto del iceberg fue más bien un «roce», como «rodar sobre un millar de canicas», como si «alguien arrastrara un dedo gigantesco por el costado del barco» o como «un sonido inquietante de algo que se rasga, como cuando se desgarra un trozo de tela».

- La metodología empleada para probar la resistencia del acero implicaba un impacto fuerte que provocaba una deformación repentina.

- Los restos del Titanic aparecen deformados, doblados o retorcidos y las placas suelen aparecer separadas por las costuras de los remaches. Las únicas zonas donde el acero aparece rajado y fracturado es por donde se partió.

Además, examinado a través del microscopio electrónico las fracturas producidas en el ensayo de Charpy, vio que las fracturas no se producían entre los límites de los granos, como cabía esperarse en el caso de un acero con un elevado contenido en azufre, sino por los granos, algo que dista bastante de un acero frágil. Así que dirigió su mirada a los remaches como posible causa del hundimiento.

Según esta teoría, las diferencias de calidad de los remaches, sumada a la diferente calidad del remachado realizado por diferentes cuadrillas de remachadores creó filas de remaches con una mayor tendencia a sufrir fallos estructurales.

Este análisis no significa que la calidad de los remaches fuera el factor determinante para que el barco se fuera a pique. Cualquier remache de calidad habría fallado con toda probabilidad frente la carga del impacto inicial, que habría provocado en cualquier caso que se abrieran varios compartimentos al mar y que el buque se hundiera al final con independencia de la eficacia de las acciones heroicas que tomaran la tripulación o sus rescatadores para salvarlo. En su lugar, el análisis considera que una mejor calidad de la materia prima con la que se hicieron los remaches podría haber cambiado la duración del hundimiento. De haberse hundido más lentamente, la palabra «Titanic» no habría cambiado permanentemente su significado en lengua inglesa.

lunes, 9 de abril de 2012

La ilusión del movimiento autocinético

Para llevar a la práctica el ejercicio que estoy a punto de explicar necesitáis estar en una habitación totalmente a oscuras, y tener un pequeño objeto luminoso. Luminoso sí, pero que no haga visible con su luz los objetos sobre los que descansa dicho objeto. Es decir, una bombilla no vale, porque la luz hace que si coloco una lámpara sobre la mesa, al encenderla podemos ver la mesa sobre la que está.

Me estoy refiriendo más bien a uno de esos objetos luminiscentes de pequeño tamaño, un piloto de un electrodoméstico podría servir también. Es decir, cualquier fuente de luz que sea visible en la oscuridad, pero que no haga visible nada más. Algo como lo de la foto…

¿Qué hay que hacer? Colocar el objeto sobre una mesa, ponerse uno luego a la mayor distancia posible dentro del cuarto y apagar la luz. Hecho esto,hay que mirar fijamente el objeto en cuestión. Quedarse quieto y mirar. Sencillo de hacer.

¿Qué ocurre? ¿Algo especial? Al poco tiempo es posible que os parezca que el objeto que acabáis de soltar empieza a ¡¿moverse solo?!

Sí, pero tranquilos, solamente lo parece. Lo que acabáis de experimentar es un efecto muy chulo que se conoce por el nombre de “ilusión de movimiento autocinético”. Parece ser que si eliminamos toda referencia del entorno nos cuesta percibir de forma adecuada si un objeto se mueve o por el contrario está quieto en las condiciones mencionadas.

Me estoy refiriendo más bien a uno de esos objetos luminiscentes de pequeño tamaño, un piloto de un electrodoméstico podría servir también. Es decir, cualquier fuente de luz que sea visible en la oscuridad, pero que no haga visible nada más. Algo como lo de la foto…

¿Qué ocurre? ¿Algo especial? Al poco tiempo es posible que os parezca que el objeto que acabáis de soltar empieza a ¡¿moverse solo?!

Sí, pero tranquilos, solamente lo parece. Lo que acabáis de experimentar es un efecto muy chulo que se conoce por el nombre de “ilusión de movimiento autocinético”. Parece ser que si eliminamos toda referencia del entorno nos cuesta percibir de forma adecuada si un objeto se mueve o por el contrario está quieto en las condiciones mencionadas.

viernes, 6 de abril de 2012

La AEMPS autoriza los primeros medicamentos homeopáticos de España

La Agencia Española de Medicamentos y Productos Sanitarios (AEMPS) ha autorizado el pasado 20 de marzo los primeros 12 registros de medicamentos homeopáticos en el mercado español.

Las 12 autorizaciones corresponden al medicamento homeopático 'Lycopodium' (licopodio) de Laboratorios DHU, autorizado en 12 diferentes potencias centesimales (CH) y decimales (DH) y en la forma farmacéutica glóbulos, la más utilizada en homeopatía.

El laboratorio comenta que 'Lycopodium' garantiza que el cultivo de las plantas utilizadas en la producción cumple con las normas de cultivo ecológico. "Ahora sólo cabe esperar que este reconocimiento de la homeopatía y sus productos siga evolucionando para una regulación completa en el futuro", señalan.

Desde la compañía señalan que "estos primeros registros podrían representar el patrón estándar más apropiado para la futura regulación de los medicamentos homeopáticos acogidos actualmente a una disposición transitoria desde 1995".

A su juicio, estas autorizaciones son la prueba que confirma la gran labor por parte de la AEMPS para posicionar a los medicamentos homeopáticos en el lugar adecuado dentro de nuestro sistema sanitario.

"A partir de ahora se podrá desarrollar un modelo como patrón para seguir en el futuro regulando los más de 19.000 expedientes que se presentaron en el año 1995 y que se encuentran en una situación de regulación transitoria", advierten.

"Que esta estrecha colaboración entre la AEMPS y los Laboratorios DHU signifique un punto de partida para iniciar una necesaria regulación total del sector y garantizar un pleno reconocimiento de todos los medicamentos homeopáticos existentes en el mercado español", concluye.

Las 12 autorizaciones corresponden al medicamento homeopático 'Lycopodium' (licopodio) de Laboratorios DHU, autorizado en 12 diferentes potencias centesimales (CH) y decimales (DH) y en la forma farmacéutica glóbulos, la más utilizada en homeopatía.

El laboratorio comenta que 'Lycopodium' garantiza que el cultivo de las plantas utilizadas en la producción cumple con las normas de cultivo ecológico. "Ahora sólo cabe esperar que este reconocimiento de la homeopatía y sus productos siga evolucionando para una regulación completa en el futuro", señalan.

Desde la compañía señalan que "estos primeros registros podrían representar el patrón estándar más apropiado para la futura regulación de los medicamentos homeopáticos acogidos actualmente a una disposición transitoria desde 1995".

A su juicio, estas autorizaciones son la prueba que confirma la gran labor por parte de la AEMPS para posicionar a los medicamentos homeopáticos en el lugar adecuado dentro de nuestro sistema sanitario.

"A partir de ahora se podrá desarrollar un modelo como patrón para seguir en el futuro regulando los más de 19.000 expedientes que se presentaron en el año 1995 y que se encuentran en una situación de regulación transitoria", advierten.

"Que esta estrecha colaboración entre la AEMPS y los Laboratorios DHU signifique un punto de partida para iniciar una necesaria regulación total del sector y garantizar un pleno reconocimiento de todos los medicamentos homeopáticos existentes en el mercado español", concluye.

Suscribirse a:

Comentarios (Atom)