Video explicativo para entender qué es un bosón y cómo está en estos momentos la investigacion de este tipo de partículas:

miércoles, 29 de febrero de 2012

Calculando Pi con gotas de agua

Existe un modo curioso de calcular el valor aproximado de π, ideal para tardes lluviosas y aburridas. Para ello, debemos dibujar un cuadrilátero, y dentro de él un círculo, de la siguiente manera:

Una vez dibujado, por ejemplo, en una cartulina, lo colocamos bajo la lluvia de modo que le caiga una buena cantidad de gotas. Como hoy hace un día soleado, simularemos las gotas con ayuda del ordenador, obteniendo algo así:

Recordando las fórmulas del área del círculo y del cuadrilátero, tenemos:

Y por último, podemos despejar π como:

En el dibujo anterior, han caído 2000 gotas sobre la cartulina, de las cuales 1565 están dentro del círculo. Tenemos pues:

En la siguiente gráfica podemos ver cómo el valor aproximado de Pi, calculado de éste modo, se aproxima al valor real cuando el número de gotas se hace grande:

Éste tipo de métodos se utilizan muy a menudo en cálculo numérico, pero en lugar de incómodas gotas de lluvia se usan puntos al azar generados por un ordenador. Se conocen como métodos de Montecarlo, en honor a sus famosos casinos (por aquello del azar).

Como al ordenador no le da pereza ponerse a contar puntitos, voy a pedirle que simule la friolera de 100000 gotitas. El resultado obtenido en un caso como ese es:

Que es evidentemente una mucho mejor aproximación.

Una vez dibujado, por ejemplo, en una cartulina, lo colocamos bajo la lluvia de modo que le caiga una buena cantidad de gotas. Como hoy hace un día soleado, simularemos las gotas con ayuda del ordenador, obteniendo algo así:

Como las gotas de lluvia se reparten al azar sobre la superficie de la cartulina, es de esperar que la probabilidad de que una gota caiga dentro del círculo sea proporcional al área del mismo, y que la probabilidad de que caiga en la cartulina sea, también, proporcional al área del a cartulina. Es decir:

Recordando las fórmulas del área del círculo y del cuadrilátero, tenemos:

Y por último, podemos despejar π como:

En el dibujo anterior, han caído 2000 gotas sobre la cartulina, de las cuales 1565 están dentro del círculo. Tenemos pues:

En la siguiente gráfica podemos ver cómo el valor aproximado de Pi, calculado de éste modo, se aproxima al valor real cuando el número de gotas se hace grande:

Éste tipo de métodos se utilizan muy a menudo en cálculo numérico, pero en lugar de incómodas gotas de lluvia se usan puntos al azar generados por un ordenador. Se conocen como métodos de Montecarlo, en honor a sus famosos casinos (por aquello del azar).

Como al ordenador no le da pereza ponerse a contar puntitos, voy a pedirle que simule la friolera de 100000 gotitas. El resultado obtenido en un caso como ese es:

Que es evidentemente una mucho mejor aproximación.

Entrevista a Caren Hagner: El error de OPERA en los neutrinos superlumínicos

R: En contra de los actuales informes sobre que el GPS no estaba funcionando, ambas fuentes potenciales de error se sitúan en los componentes electrónicos antes del detector real de OPERA. Tenemos un receptor GPS en el laboratorio de superficie. Desde allí, un cable de fibra óptica de 8 km recorre el Túnel de Gran Sasso hasta el laboratorio con el detector OPERA. El cable de fibra de vidrio está conectado a una pequeña caja, la cual convierte la seña óptica en una electrónica. Ésta llega al reloj maestro de OPERA en el túnel, justo antes del detector.

P: ¿El cable óptico se apretó torcido/inclinado/sesgado?

R: Con algo de trabajo de investigación y suerte, nos dimos cuenta de que la diferencia la creaba la forma en que se conectaba el cable. Dependiendo de la posición de la conexión, la señal traducida podía retrasarse. Detectamos que si el cable estaba inclinado sólo un poco respecto de la posición ideal, la caja pequeña sólo recibía partes de la señal. Dependiendo de la amplitud de la señal de entrada, el retardo podía ser de hasta 100 ns.

P: Entonces, la conexión torcida podría provocar que los neutrinos se moviesen más lentamente de lo que en realidad se midió…

R: Sí. No sabemos cómo de torcida estaba en realidad la conexión en el momento de nuestras medidas del año pasado. Por consiguiente, no sabemos el retardo real. Actualmente sólo podemos juzgar la magnitud del efecto. Estamos trabajando en el cálculo del efecto del enchufe basándonos en otros datos del detector. Esto llevará algún tiempo. El cable podría perfectamente ser la causa de los neutrinos superlumínicos.

P: Pero también está la corrección que necesita el reloj principal tras la caja pequeña.

A: El reloj principal contiene un oscilador. Vimos que el valor real del reloj principal difiere de un valor medido con anterioridad. Tenemos que corregir éso. Pero corregirlo aceleraría aún más los neutrinos. Por el momento parece que ambos efectos juntos pueden explicar la diferencia de 60 ns medida. Por tanto, mediríamos el tiempo exacto de llegada de los neutrinos como si hubiesen viajado a la velocidad de la luz.

P: ¿Cuál es el error de medida previsto?

R: Estamos realizando el análisis. Esperamos cuantificar el error en la medida para dentro de un par de semanas. En cualquier caso, tenemos que volver a medir con un nuevo haz de neutrinos. Es obvio.

P: ¿Y esto pasará en Mayo?

R: Sí. Para entones también podremos usar otros detectores de neutrinos – Borexino, LVD, Icarus – también situados en el Túnel de Gran Sasso, para las medidas del tiempo de vuelo. Esta sería una oportunidad para comparar todos los resultados de manera directa. Tendremos hasta cuatro sistemas distintos de medida del tiempo. Esto es importante para la credibilidad. Tenemos que medir con la máxima precisión y redundancia.

P: ¿Qué pasaría si las medidas arrojan los mismos resultados?

R: No podemos quedarnos satisfechos incluso si se desvanece el efecto de los neutrinos superlumínicos. Tenemos que buscar más posibles fuentes de error. Tenemos que comprobar el GPS y la distancia entre la fuente y el receptor. No hemos completado aún nuestra lista de comprobaciones. Por tanto, no sabemos si hay más fuentes potenciales de error.

P: ¿Cómo se gestionó todo el júbilo?

R: Ya lo vimos. Por supuesto, se nos ha preguntado por qué publicamos tan pronto. Algunos operadores de OPERA nos advirtieron de ésto.

P: Es inusual admitir errores de medida.

R: Sopesamos durante mucho tiempo si debíamos realizar este anuncio. La mayoría de los colaboradores decidieron a favor. Es importante para nosotros encontrar nuestros propios errores potenciales antes de que otros experimentos los señalen. Esto trata de credibilidad y ser capaz de criticarte a ti mismo. Por encima de todo está la credibilidad de otras medidas de OPERA – por ejemplo las medidas en la oscilación de los neutrinos con las que queremos demostrar que los neutrinos creados artificialmente cambian de identidad.

P: Sra. Hagner, gracias por la entrevista.

El liderazgo de las más viejas

Los seres humanos no somos los únicos animales en cuyos grupos hay líderes. En otras especies en las que se configuran grupos estables también los hay. Los grupos de elefantes están formados por hembras adultas y por crías e individuos jóvenes de ambos sexos. En esos grupos la hembra de más edad, la matriarca, ejerce el liderazgo: juega un papel clave en la coordinación de los movimientos del grupo y en las respuestas a las amenazas. Y la condición de líder obedece probablemente al hecho de que, al ser la hembra de más edad, cuenta con más conocimiento ecológico que el resto de miembros del grupo.

Una de las situaciones en que se puede poner a prueba el conocimiento de una matriarca es la que se produce cuando ha de afrontar la amenaza de los depredadores o cuando existe tal riesgo. Dejando aparte a los seres humanos, los leones son los principales depredadores de los elefantes africanos, y suelen atacar a crías de menos de cuatro años de edad. Cuando un grupo de elefantes es atacado por un grupo de leones, los elefantes adoptan un comportamiento de defensa cooperativo y muy agresivo que resulta bastante eficaz, por lo que no resulta nada fácil para los leones abatir a un joven elefante.

Recientemente se ha sometido a contraste experimental la capacidad de diferentes matriarcas para detectar y reaccionar a la amenaza que suponen los rugidos de leones. En los experimentos se analizaron las respuestas dadas por 39 grupos de elefantes a grabaciones de rugidos de leones que diferían en dos características: número (uno o tres) y sexo de los leones que integraban el grupo. Lógicamente, es más probable que tenga éxito un grupo de tres que un único león, y también es más probable que los leones tengan éxito si son machos, ya que son mucho más fuertes que las hembras (tienen un 50% más de masa).

En la investigación se estudiaron las siguientes respuestas: la actitud de escucha prolongada de la matriarca del grupo de elefantes, la adopción de un comportamiento defensivo de agrupamiento, la intensidad de tal agrupamiento, el cambio en la disposición de la matriarca con respecto al origen del sonido grabado, y la aproximación de los miembros del grupo hacia la matriarca.

Todos los grupos estudiados reaccionaron con mayor intensidad a las grabaciones de los rugidos de tres leones que a las de uno, algo que resulta perfectamente lógico. Pero el resultado más significativo del estudio fue que las matriarcas de más edad mostraron una mayor sensibilidad ante los rugidos de los leones macho, como mostraba el hecho de que cuanto más años tenían, más probable era que prestasen atención prolongada a las grabaciones de esos leones y que sus grupos adoptasen comportamientos defensivos. Por lo tanto, las hembras de más edad están más capacitadas para detectar con prontitud la presencia de leones macho, algo que puede resultar crucial a la hora de defender a los miembros más débiles del grupo.

Este estudio ha mostrado que las matriarcas de más edad son más capaces que las más jóvenes de distinguir diferentes niveles de amenaza dentro de un mismo tipo de depredador potencial. Y eso pone de manifiesto el valor del conocimiento acumulado a lo largo del tiempo, por la gran importancia que tiene tal conocimiento de cara a tomar decisiones de carácter colectivo de las que depende la supervivencia de alguno de los miembros del grupo. Debe tenerse en cuenta, por otro lado, que seguramente el conocimiento ecológico de las matriarcas no se limita a la capacidad para valorar la amenaza de depredadores potenciales, sino que muy probablemente también abarca a la disponibilidad y ubicación de los recursos, -de alimento, agua u otro tipo-, esenciales para la supervivencia del grupo que lideran.

Para terminar, una breve consideración acerca de nuestra especie. En las sociedades más dependientes de la explotación directa de recursos naturales, las personas de más edad han ejercido normalmente el liderazgo dentro de sus grupos; son esos a los que denominamos, arquetípica y cinematográficamente, “ancianos de la tribu”. Eran, como las matriarcas de los grupos de elefantes, las personas que acumulaban un mayor conocimiento “ecológico”. En las sociedades modernas, basadas en la industria y los servicios, el conocimiento relevante para los grupos humanos no es ese conocimiento ecológico que proporciona, ante todo, la experiencia, o no lo es de manera exclusiva, al menos. En la actualidad no es extraño que haya organizaciones gobernadas por individuos relativamente jóvenes, porque aparte de sus cualidades para dirigir grupos humanos, esos individuos jóvenes bien pueden ser los que cuenten con el conocimiento más valioso para el grupo que lideran.

sábado, 25 de febrero de 2012

Los dos posibles errores que comprometen la teoría de los neutrinos

![[foto de la noticia] [foto de la noticia]](http://estaticos04.cache.el-mundo.net/elmundo/imagenes/2012/02/23/ciencia/1329985199_0.jpg)

Según informa la web de la revista 'Science', el resultado que dio que los neutrinos eran 60 nanosegundos más rápidos que la luz se debió a una "mala conexión" entre un cable de fibra óptica que va conectado a un ordenador con receptor GPS utilizado para medir el tiempo de los neutrinos.

El propio Laboratorio Europeo de Física de Partículas (CERN) ha reconocido en un comunicado que se han identificado dos posibles fallos que ponen en tela de juicio los resultados del famoso y polémico experimento.

Dos posibles errores

El primer posible error pudo deberse a una conexión defectuosa en el cable de fibra óptica que conecta el reloj central del experimento con el GPS exterior. La segunda anomalía pudo ser un fallo en la frecuencia del oscilador del cronómetro interno del experimento.El CERN explica que estos dos fallos podrían haber producido efectos opuestos. Es decir, mientras el ajuste del cable podría suponer un aumento en la velocidad de los neutrinos, la corrección de la frecuencia podría disminuirla.

Antes de conocerse esta eventual equivocación, estaba previsto repetir los experimentos el próximo mes de mayo. Sin embargo, el portavoz del CERN James Gilles considera que esta agenda probablemente se verá alterada y los experimentos se reanudarán una vez subsanados los errores.

Gilles reconoce que los sorprendentes resultados del laboratorio ahora están en duda. "Se ha encontrado una posible explicación. Pero no lo sabremos con seguridad hasta que hayamos hecho las pruebas con un nuevo experimento", dijo Gilles.

Controversia científica

Físicos que participaron en el experimento dijeron que cuando informaron de sus resultados revisaron en múltiples ocasiones durante varios meses cualquier cosa que pudiera haber producido una lectura errónea antes de anunciar sus hallazgos.Una segunda prueba, cuyos resultados fueron anunciados en noviembre, pareció confirmar que los neutrinos viajaban más rápido que la luz. Pero muchos expertos se mantenían escépticos frente a un resultado que habría anulado uno de los principios fundamentales de la física moderna.

Edward Blucher, presidente del Departamento de Física de la Universidad de Chicago, dijo que el hallazgo original habría sido impresionante si hubiese sido cierto. En su momento, la investigación provocó mucha controversia en la comunidad científica, pero muy pocos físicos defendían la validez de los resultados, y la mayoría estaba convencida de que tenían que deberse a un error.

"No creo que haya conocido a nadie que dijera que apostaba a que era cierto. Creo que la gente del experimento trabajó de forma tan cuidadosa como pudo y creo que se les acabaron las ideas sobre qué pudo haber salido mal y decidieron presentarlo", declaró.

"Quizás debieron haber esperado unos pocos meses más", agregó.

¿Estamo solos en el universo?

Un discurso del astrofísico y divulgador científico Neil deGrasse Tyson sobre la posibilidad de vida extraterrestre.

Cuando el sol apaga la luz en tu casa

El astrónomo de la NASA Sten Odenwald, explica que tres días antes se había registrado una explosión solar que expulsó millones de toneladas de gas, con una fuerza similar a la de miles de bombas nucleares explotando a la vez. La nube se dirigió a la Tierra, y la llamarada resultante, además de provocar auroras boreales que se pudieron ver en Florida o Cuba, causó inmediatamente interferencias en la onda corta de radio. Por ejemplo, la Radio Europa Libre de Rusia se quedó sin señal, creyendo que había sido obra del Kremlin.

Pero los efectos provocados por esta tormenta no quedaron ahí. Durante la tarde del 12 de marzo, la enorme nube de plasma solar (un gas cargado por partículas eléctricas) alcanzaba finalmente el campo magnético de la Tierra. Las corrientes eléctricas causadas encontraron un punto débil en la red energética de Quebec, lo que provocó un corte que duró 12 horas, dejando a millones de personas sin luz. En el espacio, la tormenta también se hizo notar. Algunos satélites se quedaron sin control durante horas, e incluso la lanzadera Discovery tuvo problemas.

Los ingenieros eléctricos y los científicos especializados en el espacio siguen contando “el apagón de Quebec” como un ejemplo de lo que puede ocurrir con una fuerte tormenta solar. No obstante, la intensidad de aquella ocasión se produce de forma bastante rara, según Odenwald. Los ciclos típicos de las manchas solares pueden producir al menos dos o tres grandes tormentas por lo que, como subraya el astrónomo de la NASA, cuánto más se pueda conocer sobre estos fenómenos, más preparados podremos estar para la próxima tormenta potente que pueda suceder.

Así es una explosión solar afectando a la Tierra

En esta animación de la NASA se muestra un ejemplo de erupciones solares y eyecciones de masa coronal (EMC), asociadas a nubes gigantes de plasma en el espacio. Se trata de las mayores explosiones en el sistema solar, y son causadas por la acumulación y la liberación repentina de tensión magnética en la atmósfera solar por encima de las gigantes manchas solares. Las EMC pueden causar tormentas magnéticas que afectan a los sistemas de comunicación, las redes eléctricas y a los astronautas en el espacio.

Qué es una tormenta solar

Una tormenta solar se produce cuando una eyección de masa coronal (EMC), una llamarada proveniente del sol, choca con la magnetosfera terrestre. La onda de choque de viento solar llega entre 24 y 36 horas después de la explosión.

El fenómeno se produce básicamente en tres etapas. La primera, la erupción solar, tarda ocho minutos en llegar, y puede alterar las comunicaciones por ondas y las órbitas de los satélites. Posteriormente, se produce una tormenta de radiación, un bombardeo de radiación contra la Tierra que puede afectar a las redes eléctricas y a los astronautas que no estén debidamente protegidos. Finalmente la EMC es la onda más peligrosa, ya que daña a los satélites, los transformadores eléctricos y las comunicaciones.

Las lluvias de estrellas del 2012

Las lluvias de estrellas son un fenómeno astronómico realmente interesante. Son útiles para iniciarse mínimamente en el conocimiento de las constelaciones que vemos a diario (siempre que la contaminación lumínica nos lo permita), no necesitamos saber mucho de astronomía para disfrutarlas, y además no requieren de utensilios especiales para su observación.

Las lluvias de estrellas ocurren cuando la Tierra intercepta y atrae hacia sí, quemándolos en la atmósfera, los fragmentos que deja un asteroide o un cometa en su órbita.

¿Qué lluvias de estrellas tendrán lugar en 2012?

Las cuadrántidas

Esta lluvia recibe su nombre de la ya obsoleta constelación Quadrans Muralis, creada en 1795 por el astrónomo francés Joseph Jerome, y que representa un cuadrante mural, instrumento que él y su sobrino usaban para sus observaciones en el cielo. Estos meteoros, de velocidad moderada, radian (es decir, parece que surjan en el cielo) de la constelación de Boötes, el pastor.

Los astrónomos creen que el causante de esta lluvia es el asteroide 2003 EH1, descubierto en 2003-2004. Su visibilidad oscila entre el 1 y el 5 de enero, alcanzando su punto álgido el 3 y el 4. Al final de la noche, el radiante de las cuadrántidas queda rodeado por la Osa Mayor y Menor, Boötes, la Corona Boreal, Hércules y el Dragón. Este año la mejor ubicación para observar las cuadrántidas ha sido el oeste de Europa, el norte del Atlántico y el norte de América del Este.

Las líridas

Esta lluvia de estrellas es de actividad moderada. Se desarrollan del 16 al 25 de abril y su máxima actividad está prevista para el día 21, coincidiendo con la luna nueva. Este año es una buena oportunidad para proponerse la observación de las líridas, ya que la luna nueva despejará el cielo de luz innecesaria y permitirá que el espectáculo se observe con claridad.

Los meteoros de la líridas son originados por el cometa Thatcher (C/1861 G1).

Eta Acuáridas

Esta lluvia es causada por el famoso cometa Halley y sus 76 años de órbita solar. Son llamadas así porque su punto radiante es cercano a la estrella Eta de Acuario.

Sus días de apogeo serán el día 5 y 6 de mayo, aunque la mayor luna llena del año ofuscará el cielo, por lo que es mejor usar la noche del día 3 para su observación.

La observación de este acontecimiento del firmamento es aconsejable hacia el final de la noche, y se verán mejor desde el sur de España.

Delta Acuáridas

La lluvia de estrellas Delta Acuáridas se extiende del 14 de Julio al 18 de Agosto. Su período de máxima actividad acontece entre el 28 y el 30 de Julio. El nombre proviene de su radiante, la estrella Delta de Acuario.

Son originadas por los Rasantes de Kreutz Marsden y Kracht.

Las Perseidas

Las Perseidas, también conocidas como “Las lágrimas de San Lorenzo”, es una lluvia de estrellas de actividad alta. Posiblemente es la más popular y observada de todas ellas en el hemisferio Norte, porqué tienen lugar en verano y hay más tiempo disponible para su observación.

Su nombre proviene del punto radiante en el cielo, la constelación de Perseo. Esta lluvia de estrellas es difícilmente visible desde cielos australes y encuentran su origen en el cometa 109P/Swift-Tuttle.

Este año será visible desde mediados de julio hasta casi el fin de agosto, pero será el día 12 cuando se registra su mayor actividad. El mejor momento para observarlas será al inicio del alba, sin ser obstaculizadas por la luna menguante.

Las Dracónidas

Esta lluvia de estrellas es causada por el rastro que deja el cometa 21P/Giacobini-Zinner, así que algunas veces también reciben el nombre de Giacobínidas.

El nombre más usado, Dracónidas, se le es otorgado porqué parece que surjan de la constelación del Dragón. Aunque es ya visible en los primeros días de octubre, del 8 al 10 de octubre es cuando alcanzan su mayor esplendor.

Las Oriónidas

El cometa progenitor de las Oriónidas es, como de las Eta Acuáridas, es el cometa Halley.

Se observan mejor de madrugada y, aunque son visibles durante todo el mes de octubre, su máxima actividad ocurre el día 21. Su actividad es moderada, su velocidad es generalmente alta, y como su nombre indica su punto radiante es la constelación de Orión.

Las Táuridas

Las lluvias de estrellas de las Táuridas (del Norte y del Sur) son la parte que más despunta en el llamado complejo eclíptico, en el que se integran los meteoroides cuya órbita es muy próxima al plano de la eclíptica terrestre.

A la hora de observarlas, en esta pareja de lluvias encontramos unos radiantes amplios y precariamente delimitados, junto con unos meteoritos rutilantes y lentos.

El punto culminante de la Táuridas del Sur es la noche del 4 al 5 de noviembre, mientras que el de las Táuridas del Norte será el día 10 este año.

Las Leónidas

Los meteoros que se agrupan en las Leónidas (cuyo radiante es la constelación de Leo) se caracterizan por la rapidez con que atraviesan la atmósfera terrestre (unos 70 km/h) y por los bólidos brillantes que dejan tras de sí una estela verdosa.

El cuerpo que las origina es el cometa 55P/Tempel-Tuttle y su órbita provoca unas intensas tormentas de meteoros aproximadamente cada 33 años.

Este año 2012 se observarán durante la mayor parte del mes, desde la primera semana hasta casi el último día de noviembre, siendo el día 17 el de mayor actividad.

Las Gemínidas

Probablemente la lluvia de las Gemínidas es la más notable del año junto con las Cuadrántidas. Será visible ya desde comienzos del mes de diciembre, y se espera que este año el día en que sea más intensa sea el 13, sin la Luna como interferencia.

Son de baja velocidad y sus entre sus meteoros destacan los variados colores.

Su radiante va alcanzando altura conforme avanza la segunda mitad de la noche.

Se ha identificado la desintegración de los asteroides (3200) Phaethon y (155140) 2005 UD como causantes de las Gemínidas.

La datación por Carbono-14

Seguro que has oído alguna vez que se ha usado la “prueba del carbono-14” (C-14) para determinar la antigüedad de alguna muestra biológica, como restos humanos, una pieza de madera o incluso fibras de tejido (como la “sábana santa” de Turín).

Como seguro sabrás, un mismo elemento químico viene en la Naturaleza en distintos “sabores”, con la particularidad de que todos ellos parecen idénticos, reaccionan con las mismas sustancias, etc. Solamente se diferencian entre sí, muy ligeramente, en sus masas atómicas. Son los isótopos de un elemento.

El aire que expulsas al respirar está lleno de dióxido de carbono (CO2), proveniente de la “quema” (reacción con oxígeno, O2) de moléculas ricas en carbono (C) que el cuerpo utiliza para sacar la energía que nos mantiene vivos. Ese carbono, en forma de glucosa o de hidratos de carbono, viene a su vez de lo que comemos que, en última instancia, se origina en las plantas que lo capturan del aire al realizar la fotosíntesis.

Por lo tanto, con cada respiración estás cerrando un largo ciclo, devolviendo a la atmósfera el carbono fijado por plantas dios sabe dónde hace semanas o meses. Lo mismo, pero a escalas industriales y remontándonos al carbono fijado hace millones de años es lo que ocurre al quemar carbón o petróleo.

Lo curioso de este ciclo es que no importa qué isótopos del elemento carbono formen parte de él: ni las plantas ni tu cuerpo discrimina entre ellos, ya que todos le parecen iguales. ¡Recuerda que los isótopos son todos químicamente idénticos!

Por tanto, cabe esperar que el carbono fijado por las plantas contenga, de media (pero de forma muy precisa), la misma proporción de isótopos que el aire de la atmósfera. De los tres isótopos que se encuentran en la naturaleza, el C-12 y el C-13 son estables y representan el 99% del carbono en la Tierra. El 1% restante es radiactivo y, como adivinarás, es el famoso C-14.

Durante la vida de las plantas y animales, estamos continuamente intercambiando carbono con el entorno, por lo que lo normal es que mantengamos un porcentaje de C-14 aproximadamente constante en relación al resto de isótopos, e igual al porcentaje de equilibrio que existe en la Tierra.

Pero al morir, el intercambio cesa y solamente queda la desintegración radiactiva de tipo decaimiento beta por la que el C-14 se convierte, por arte de magia, en nitrógeno.

El proceso de desintegración es aleatorio, pero sigue un patrón perfectamente conocido. Así que si medimos el porcentaje de C-14 que queda en una muestra y conocemos la concentración inicial (la de la última atmósfera que respiró el ser vivo antes de morir) es cuestión de matemáticas despejar el tiempo de la ecuación y voilà, ¡hemos averiguado los años que lleva muerta nuestra muestra!

La pega está, claro, en saber cómo era la atmósfera de tiempos pasados. Los científicos creen que, exceptuando variaciones menores debidos a cambios en el sol y en el clima, el porcentaje de C-14 se ha mantenido bastante estable durante decenas de miles de años… hasta la década de 1950, época en que comenzó la carrera por ver qué país explotaba la bomba nuclear más gorda en nuestra propia atmósfera.

Lo peor, a efectos de datación mediante C-14 es la gran incertidumbre sobre cuáles fueron los niveles medios del isótopo en cada lugar del planeta durante la segunda mitad del siglo XX, ya que un valor casi constante durante milenios de pronto estaba pegando brincos por semanas. Y sin un valor inicial fiable, la concentración medida en una muestra bajo estudio no nos dice absolutamente nada.

¿Cuándo dirías que se firmó el primer tratado internacional de prohibición de ensayos nucleares? Fue en 1963, así que imagina hasta dónde podría haber llegado la concentración de isótopos de haber continuado la loca carrera nuclear.

Extras

Extra 1: Para los que quieran saber un poco más sobre los métodos para medir cuánto C-14 hay en una muestra, podéis ver esta página donde resume el método “barato” de extracción del carbono por medios químicos. Existe una alternativa, mucho más cara pero más precisa y que permite trabajar con muestras de miligramos, basada en espectroscopia de masas con la luz de un acelerador de partículas.

Extra 2: Quizás te hayas percatado de un punto importante que me he saltado arriba: ¿si el C-14 es inestable, cómo puede existir un equilibrio en la atmósfera? ¿No debería existir alguna fuente de C-14?

Efectivamente, esa fuente natural de C-14 existe y se debe a las reacciones (nucleares) que tienen lugar en las capas altas de la atmósfera. Los rayos cósmicos generan reacciones en cadena al chocar con los núcleos de las moléculas del aire, y algunos de los neutrones que salen despedidos a toda velocidad chocan con núcleos de nitrógeno y se transforman (¡magia de la física!) en carbono, del tipo C-14.

Extra 3: Realmente, no es imposible datar una muestra posterior al año 1950 por medio del C-14. Pero además del problema de obtener valores de referencia precisos existe una complicación añadida: para un extenso rango de valores de concentraciones existen dos o más “picos de probabilidad” (distribución de probabilidad multimodal) sobre potenciales dataciones.

Como se ve en la gráfica, para un valor medido (una línea horizontal) se cortaría a la gráfica de concentraciones en más de un punto, como el ejemplo que no podríamos saber si data de ~1963 o de ~1985:

Extra 4: Otra complicación más para dataciones recientes proviene de la quema de combustibles fósiles, que están liberando a la atmósfera isótopos C-14 que llevaban encerrados bajo tierra millones de años.

El método funciona perfectamente para restos de hace 20 mil años, pero no para los de hace sólo 50 o 60 años. ¿Te imaginas por qué?

Como seguro sabrás, un mismo elemento químico viene en la Naturaleza en distintos “sabores”, con la particularidad de que todos ellos parecen idénticos, reaccionan con las mismas sustancias, etc. Solamente se diferencian entre sí, muy ligeramente, en sus masas atómicas. Son los isótopos de un elemento.

El aire que expulsas al respirar está lleno de dióxido de carbono (CO2), proveniente de la “quema” (reacción con oxígeno, O2) de moléculas ricas en carbono (C) que el cuerpo utiliza para sacar la energía que nos mantiene vivos. Ese carbono, en forma de glucosa o de hidratos de carbono, viene a su vez de lo que comemos que, en última instancia, se origina en las plantas que lo capturan del aire al realizar la fotosíntesis.

Por lo tanto, con cada respiración estás cerrando un largo ciclo, devolviendo a la atmósfera el carbono fijado por plantas dios sabe dónde hace semanas o meses. Lo mismo, pero a escalas industriales y remontándonos al carbono fijado hace millones de años es lo que ocurre al quemar carbón o petróleo.

Por tanto, cabe esperar que el carbono fijado por las plantas contenga, de media (pero de forma muy precisa), la misma proporción de isótopos que el aire de la atmósfera. De los tres isótopos que se encuentran en la naturaleza, el C-12 y el C-13 son estables y representan el 99% del carbono en la Tierra. El 1% restante es radiactivo y, como adivinarás, es el famoso C-14.

Durante la vida de las plantas y animales, estamos continuamente intercambiando carbono con el entorno, por lo que lo normal es que mantengamos un porcentaje de C-14 aproximadamente constante en relación al resto de isótopos, e igual al porcentaje de equilibrio que existe en la Tierra.

Pero al morir, el intercambio cesa y solamente queda la desintegración radiactiva de tipo decaimiento beta por la que el C-14 se convierte, por arte de magia, en nitrógeno.

El proceso de desintegración es aleatorio, pero sigue un patrón perfectamente conocido. Así que si medimos el porcentaje de C-14 que queda en una muestra y conocemos la concentración inicial (la de la última atmósfera que respiró el ser vivo antes de morir) es cuestión de matemáticas despejar el tiempo de la ecuación y voilà, ¡hemos averiguado los años que lleva muerta nuestra muestra!

La pega está, claro, en saber cómo era la atmósfera de tiempos pasados. Los científicos creen que, exceptuando variaciones menores debidos a cambios en el sol y en el clima, el porcentaje de C-14 se ha mantenido bastante estable durante decenas de miles de años… hasta la década de 1950, época en que comenzó la carrera por ver qué país explotaba la bomba nuclear más gorda en nuestra propia atmósfera.

Con cada detonación se liberaron al aire numerosos isótopos radiactivos, muchos de corta vida, y otros como el C-14, de no tan corta (~5700 años de vida media). Durante unos años, la concentración en el hemisferio norte casi llegó a duplicarse.Lo peor, a efectos de datación mediante C-14 es la gran incertidumbre sobre cuáles fueron los niveles medios del isótopo en cada lugar del planeta durante la segunda mitad del siglo XX, ya que un valor casi constante durante milenios de pronto estaba pegando brincos por semanas. Y sin un valor inicial fiable, la concentración medida en una muestra bajo estudio no nos dice absolutamente nada.

¿Cuándo dirías que se firmó el primer tratado internacional de prohibición de ensayos nucleares? Fue en 1963, así que imagina hasta dónde podría haber llegado la concentración de isótopos de haber continuado la loca carrera nuclear.

Extras

Extra 1: Para los que quieran saber un poco más sobre los métodos para medir cuánto C-14 hay en una muestra, podéis ver esta página donde resume el método “barato” de extracción del carbono por medios químicos. Existe una alternativa, mucho más cara pero más precisa y que permite trabajar con muestras de miligramos, basada en espectroscopia de masas con la luz de un acelerador de partículas.

Extra 2: Quizás te hayas percatado de un punto importante que me he saltado arriba: ¿si el C-14 es inestable, cómo puede existir un equilibrio en la atmósfera? ¿No debería existir alguna fuente de C-14?

Efectivamente, esa fuente natural de C-14 existe y se debe a las reacciones (nucleares) que tienen lugar en las capas altas de la atmósfera. Los rayos cósmicos generan reacciones en cadena al chocar con los núcleos de las moléculas del aire, y algunos de los neutrones que salen despedidos a toda velocidad chocan con núcleos de nitrógeno y se transforman (¡magia de la física!) en carbono, del tipo C-14.

Como se ve en la gráfica, para un valor medido (una línea horizontal) se cortaría a la gráfica de concentraciones en más de un punto, como el ejemplo que no podríamos saber si data de ~1963 o de ~1985:

Extra 4: Otra complicación más para dataciones recientes proviene de la quema de combustibles fósiles, que están liberando a la atmósfera isótopos C-14 que llevaban encerrados bajo tierra millones de años.

domingo, 19 de febrero de 2012

Los sonidos del espacio

La Agencia Espacial Europea ha publicado un breve video con un resumen de las músicas que han sonado en las numerosas misiones que han viajado hasta el espacio. Desde el “Man on the moon” de los REM hasta mis queridos Dire Straits…

Un mini documental de 12 minutos con algunas de las curiosidades musicales que han ocurrido ahí arriba, incluido el pequeño concierto con el que el astronauta Thomas Reiter obsequió con su guitarra a bordo de la MIR.

Un mini documental de 12 minutos con algunas de las curiosidades musicales que han ocurrido ahí arriba, incluido el pequeño concierto con el que el astronauta Thomas Reiter obsequió con su guitarra a bordo de la MIR.

jueves, 16 de febrero de 2012

La antigüedad de las clases sociales

Hace 13.000 años, las comunidades humanas que habitaban el sur de Siria comenzaban a exhibir una diferenciación social, según los análisis de un yacimiento en el que ha participado el Consejo Superior de Investigaciones Científicas (CSIC).

El poblado completo, denominado Qarassa 3, se compone de 12 cabañas, dos de las cuales muestran un nivel de complejidad superior al resto. Según el investigador del CSIC en la Institución Milá y Fontanals Juan José Ibáñez, "esta característica podría indicar una diferencia en el rol social de sus habitantes". De las cabañas, se conserva la base de los muros, erigidos con piedras basálticas.

Gracias a ellas, se sabe que las estancias eran circulares, de entre cuatro y cinco metros de diámetro. La existencia de agujeros de poste sugiere que la cubierta y el alzado de las paredes eran de materia vegetal.

Las dos viviendas con un mayor nivel de complejidad son las que están situadas en la zona más meridional del poblado. Una de ellas presenta divisiones internas y una pequeña plataforma interior sobreelevada, y la otra consta de una fosa y dos plataformas exteriores asociadas a la puerta de entrada. Para el responsable de la excavación, el investigador del CSIC en el mismo centro que Ibáñez, Xavier Terradas, "la estructuración del espacio interior es un hallazgo clave en la historia de la arquitectura".

Las estancias tienen entre 12 y 16 metros cuadrados de superficie, por lo que Terradas interpreta que el poblado debía componerse de entre 40 y 60 individuos. El investigador del CSIC explica: "La distribución de todas ellas, adyacentes entre sí, pero no superpuestas y organizadas en forma de arco orientado hacia un antiguo lago, demuestra que todas formaban parte de un mismo poblado".

Ibáñez detalla: "No podemos saber con seguridad si vivían todo el año en esas cabañas o sólo durante largos periodos, pero supone un gran asentamiento frente a las comunidades nómadas. La sedentarización trajo consigo la aparición de la ganadería y la agricultura, y el abandono de la caza y la recolección". Según el investigador del CSIC, "no se han encontrado indicios de agricultura en el poblado, pero sí se ha comprobado una mayor explotación de los cereales ya que han aparecido más de 80 morteros excavados en la roca de los alrededores, además de utensilios para la siega".

Para dilucidar la importancia de la agricultura dentro de esta comunidad el equipo planea una nueva expedición para analizar los sedimentos del lago seco. Según Ibáñez, "este proyecto podría revelar indicios de cultivos cerca de la orilla". El hallazgo del poblado tuvo lugar cerca de la ciudad de Sweida, al sur de Siria. Fue encontrado por arqueólogos del Centro Nacional de Investigaciones de Francia en 2005. El equipo de investigación solicitó ayuda para los análisis al equipo de Ibáñez y al Instituto Internacional de Investigaciones Prehistóricas de Cantabria (unidad asociada al CSIC y perteneciente a Universidad de Cantabria).

El poblado completo, denominado Qarassa 3, se compone de 12 cabañas, dos de las cuales muestran un nivel de complejidad superior al resto. Según el investigador del CSIC en la Institución Milá y Fontanals Juan José Ibáñez, "esta característica podría indicar una diferencia en el rol social de sus habitantes". De las cabañas, se conserva la base de los muros, erigidos con piedras basálticas.

Gracias a ellas, se sabe que las estancias eran circulares, de entre cuatro y cinco metros de diámetro. La existencia de agujeros de poste sugiere que la cubierta y el alzado de las paredes eran de materia vegetal.

Las dos viviendas con un mayor nivel de complejidad son las que están situadas en la zona más meridional del poblado. Una de ellas presenta divisiones internas y una pequeña plataforma interior sobreelevada, y la otra consta de una fosa y dos plataformas exteriores asociadas a la puerta de entrada. Para el responsable de la excavación, el investigador del CSIC en el mismo centro que Ibáñez, Xavier Terradas, "la estructuración del espacio interior es un hallazgo clave en la historia de la arquitectura".

Las estancias tienen entre 12 y 16 metros cuadrados de superficie, por lo que Terradas interpreta que el poblado debía componerse de entre 40 y 60 individuos. El investigador del CSIC explica: "La distribución de todas ellas, adyacentes entre sí, pero no superpuestas y organizadas en forma de arco orientado hacia un antiguo lago, demuestra que todas formaban parte de un mismo poblado".

Empieza el sedentarismo

Las características del yacimiento lo incluyen dentro de la cultura natufiense, que habitó esta región hace entre 14.000 años y 9.000 años aproximadamente. El hallazgo, por tanto, asienta los rasgos de esta cultura, asociada al principio de la sedentarización.Ibáñez detalla: "No podemos saber con seguridad si vivían todo el año en esas cabañas o sólo durante largos periodos, pero supone un gran asentamiento frente a las comunidades nómadas. La sedentarización trajo consigo la aparición de la ganadería y la agricultura, y el abandono de la caza y la recolección". Según el investigador del CSIC, "no se han encontrado indicios de agricultura en el poblado, pero sí se ha comprobado una mayor explotación de los cereales ya que han aparecido más de 80 morteros excavados en la roca de los alrededores, además de utensilios para la siega".

Para dilucidar la importancia de la agricultura dentro de esta comunidad el equipo planea una nueva expedición para analizar los sedimentos del lago seco. Según Ibáñez, "este proyecto podría revelar indicios de cultivos cerca de la orilla". El hallazgo del poblado tuvo lugar cerca de la ciudad de Sweida, al sur de Siria. Fue encontrado por arqueólogos del Centro Nacional de Investigaciones de Francia en 2005. El equipo de investigación solicitó ayuda para los análisis al equipo de Ibáñez y al Instituto Internacional de Investigaciones Prehistóricas de Cantabria (unidad asociada al CSIC y perteneciente a Universidad de Cantabria).

El español en busca de neutrinos

El físico español Carlos Pobes, de la Universidad de Zaragoza, ha comenzado su aislamiento de ocho meses en la base científica estadounidense Amundsen-Scott en la Antártida, donde estará incomunicado. El 'Winter Over', un periodo donde la base queda aislada en completa oscuridad y con temperaturas que pueden llegar a los -80º C, ha comenzado y el último avión presente en la base ha abandonado el emplazamiento.

Hasta el próximo mes de octubre, Carlos Pobes se hará cargo del telescopio de neutrinos IceCube, un experimento que involucra a 39 institutos de investigación de 11 países y que trata de detectar neutrinos con una serie de detectores enterrados en el hielo antártico.

Este telescopio aprovecha los casi 3 kilómetros de espesor del hielo antártico para capturar neutrinos procedentes de todos los rincones del Universo.

Primera fotografía del Universo

Se espera que el IceCube obtenga una "primera fotografía" del Universo con neutrinos y servirá, además, para recabar información fundamental para resolver misterios como el origen de los rayos cósmicos, precisa la UZ en un comunicado.Completado en varias fases, el IceCube lleva menos de un año tomando datos en su configuración final, que cubre un kilómetro cúbico de volumen. Los neutrinos son partículas eléctricamente neutras, cuya masa es inapreciable y es tan esquiva que se requieren enormes volúmenes para situar los detectores y largos tiempos de exposición para poder capturar un número suficiente.

Además, algunos fenómenos astrofísicos que producen neutrinos pueden durar sólo unos segundos, por lo que se hace imprescindible que el detector esté tomando datos de manera continua, y tanto Pobes como su colega sueco deberán garantizar el correcto funcionamiento del telescopio en un ambiente de extrema crudeza térmica.

La particular ubicación de la base Amundsen-Scott, situada en el Polo Sur del planeta, la hace ideal para estudios de diversa índole, desde climatología hasta cosmología. Situada a casi 3.000 metros de altitud en medio de la meseta antártica, la temperatura media anual en la base ronda los -50º C, y pueden llegar a alcanzarse incluso los -80º C en invierno.

Accesible sólo durante cuatro meses

Eso hace que sólo durante cuatro meses al año sea posible volar allí y el resto del año la base queda completamente incomunicada y unas 50 personas permanecen aisladas en ella para garantizar el correcto funcionamiento de los distintos experimentos.Pobes, natural de la localidad zaragozana de Gallur, es el tercer español en la historia que vivirá en situación de aislamiento en la base, tras Luis Aldaz (1965) y Francisco Navarro (1984), y será el primero en el experimento IceCube.

El investigador aragonés fue seleccionado entre 50 candidatos de todo el mundo por la Universidad de Wisconsin-Madison (EEUU) tras superar un proceso de selección con rigurosas pruebas médicas y psicológicas.

"Serán seis meses de aislamiento total con temperaturas medias inferiores a los 60 grados centígrados bajo cero", comenta Pobes por correo electrónico desde la base, en la que se encuentra desde octubre pasado para aclimatarse a las condiciones de vida.

"Pero también tendremos la oportunidad de disfrutar de la noche polar y sus espectaculares auroras, un privilegio que solo un reducido grupo de personas puede contemplar cada año", agrega, según la nota difundida por la UZ.

El "suicidio" de la ciencia española

La revista científica 'Nature' ha publicado una carta de la astrofísica Amaya Moro-Martín, miembro también de la plataforma Investigación Digna, en la que lamenta los recortes presupuestarios en ciencia y la falta de una política de estado y denuncia que la investigación en España supone "misión imposible".

En la misiva, que ya fue publicada el pasado mes de diciembre por ELMUNDO.es, Moro describe que en la actual estructura del Gobierno ya no hay Ministerio de Ciencia y que las competencias de la política científica han pasado al Ministerio de Economía y Competitividad y muestra su preocupación ante la señal de alarma que se ha enviado con el ya anunciado recorte de 600 millones de euros.

"Es la primera vez que ni ciencia ni investigación tienen nombre en uno de los ministerios", indica esta investigadora, quien opina que no se trata sólo de un cambio "simbólico", sino de la constatación de que existe una "tendencia deliberada de socavar y minimizar la importancia de la ciencia" y de que ésta continúa.

Si bien reconoce que España está inmersa en una crisis económica y en un plan de ajuste económico, esta astrofísica critica que las acciones "irracionales y draconianas" del Gobierno pueden provocar a largo plazo daños en los cimientos de la ciencia española.

No obstante, el problema no ha empezado con el nuevo Gobierno, advierte Moro, quien lamenta los recortes en la oferta pública de empleo de los últimos años y subraya el futuro "desolador".

Este panorama, apunta, está provocando que algunos investigadores rechacen becas en España, entre ellas las del programa Ramón y Cajal.

"La congelación en la contratación es un suicidio", según esta investigadora, quien recuerda que las plazas de aquellos científicos que se jubilan no se reponen y España tiene una "limitada" industria científica y tecnológica para absorber a estos expertos.

Esto provocará, según Moro, que científicos cualificados de entre 20 y 40 años tengan que irse de España, "una fuga de cerebros" de varias generaciones, con la consiguiente pérdidas en la innovación y credibilidad, "un daño que tardará décadas en reponerse".

A su juicio, el nuevo Gobierno está "pisoteando" las mejores esperanzas de los investigadores españoles.

Para esta astrofísica, quien ayer se reunió con los grupos parlamentarios, la situación en España se puede resumir con un cartel de una superproducción de Hollywood, en el que se lee: "sin plan, sin apoyo, sin opción. Misión imposible. Protocolo fantasma". En este sentido, dice: "la investigación en España es misión imposible".

En la misiva, que ya fue publicada el pasado mes de diciembre por ELMUNDO.es, Moro describe que en la actual estructura del Gobierno ya no hay Ministerio de Ciencia y que las competencias de la política científica han pasado al Ministerio de Economía y Competitividad y muestra su preocupación ante la señal de alarma que se ha enviado con el ya anunciado recorte de 600 millones de euros.

"Es la primera vez que ni ciencia ni investigación tienen nombre en uno de los ministerios", indica esta investigadora, quien opina que no se trata sólo de un cambio "simbólico", sino de la constatación de que existe una "tendencia deliberada de socavar y minimizar la importancia de la ciencia" y de que ésta continúa.

Si bien reconoce que España está inmersa en una crisis económica y en un plan de ajuste económico, esta astrofísica critica que las acciones "irracionales y draconianas" del Gobierno pueden provocar a largo plazo daños en los cimientos de la ciencia española.

Fuga de cerebros

Además, añade, con estas políticas y recortes se mandan mensajes contradictorios a otros países e investigadores, ya que por un lado se habla del cambio de modelo productivo a uno basado en el conocimiento y por otra "no se hace nada por proteger" la ciencia.No obstante, el problema no ha empezado con el nuevo Gobierno, advierte Moro, quien lamenta los recortes en la oferta pública de empleo de los últimos años y subraya el futuro "desolador".

Este panorama, apunta, está provocando que algunos investigadores rechacen becas en España, entre ellas las del programa Ramón y Cajal.

"La congelación en la contratación es un suicidio", según esta investigadora, quien recuerda que las plazas de aquellos científicos que se jubilan no se reponen y España tiene una "limitada" industria científica y tecnológica para absorber a estos expertos.

Esto provocará, según Moro, que científicos cualificados de entre 20 y 40 años tengan que irse de España, "una fuga de cerebros" de varias generaciones, con la consiguiente pérdidas en la innovación y credibilidad, "un daño que tardará décadas en reponerse".

A su juicio, el nuevo Gobierno está "pisoteando" las mejores esperanzas de los investigadores españoles.

Para esta astrofísica, quien ayer se reunió con los grupos parlamentarios, la situación en España se puede resumir con un cartel de una superproducción de Hollywood, en el que se lee: "sin plan, sin apoyo, sin opción. Misión imposible. Protocolo fantasma". En este sentido, dice: "la investigación en España es misión imposible".

El robot sensible

Científicos de la Universidad de Keio (Japón) han desarrollado el primer robot 'sensible' que es capaz de ver, oír y sentir al tacto. Esta máquina, con forma humana, puede, a través de un traje sensible vestido por el operador, reproducir a la perfección los movimientos del mismo. Al mismo tiempo, los sensores instalados en el robot permiten que su 'conductor' reciba sus sensaciones.

Los expertos han indicado que el robot, bautizado como Telesar V, es una máquina capaz de moverse de la misma forma que un ser humano y es operado remotamente mediante una especie de traje que registra los movimientos de su operador y los transmite al robot, que se limita a repetirlos. Este control incluye los movimientos de las extremidades, cabeza y manos, permitiéndole asir o manipular objetos de forma remota.

Además, el robot puede proporcionar a su operador un flujo de datos, mediante el uso de un casco de realidad virtual que le permite ver lo que las cámaras, instaladas al modo de ojos, registran y oír lo que los micrófonos captan. Del mismo modo, unos sofisticados guantes de poliéster le hacen 'sentir' lo que el robot esté tocando.

En cuanto a su utilidad, los científicos han señalado que Telesar V podrá introducirse en ambientes donde el ser humano no pueda hacerlo por cuestiones de seguridad. Según ha explicado su creador, Susumu Tachi, al 'Daily Telegraph', el robot "será capaz de llegar a lugares demasiado peligrosos para los humanos y cumplir tareas que requieran una habilidad humana".

El equipo que ha llevado a cabo este proyecto lo compara con los protagonistas de la película de James Cameron 'Avatar'. En el filme los soldados participan en un programa en el que sus mentes se pueden transportar a cuerpos artificiales y eran capaces de controlar de forma remota los organismos genéticamente modificados de una raza extraterrestre.

Camaleones enanos

Un grupo de investigadores alemanes ha descubierto cuatro nuevas especies de reptiles miniatura en Madagascar. Según detallan en la revista científica de libre acceso 'PLoS ONE', se trata de camaleones de tan sólo unas decenas de milímetros desde la cabeza hasta la cola.

Alguna de las especies es lo suficientemente pequeña como para sostenerse sobre la cabeza de una cerilla. Los autores de la investigación concluyen que estos animales se encuentran entre los reptiles más pequeños del mundo.

Los investigadores, dirigidos por Frank Glaw de la Colección Estatal Zoológica de Munich (Alemania), también llevaron a cabo un análisis genético para determinar que los lagartos miniatura, si bien son muy similares en apariencia, son de hecho especies distintas.

La especie más pequeña del grupo, 'Brookesia micra', sólo se ha encontrado en un islote muy pequeño llamado Nosy Hara y situado al norte de la isla principal de Madagascar. Los científicos sugieren en el artículo científico que esta especie puede representar un caso extremo de enanismo exclusivo de la isla.

"La miniaturización extrema de estos reptiles enanos puede ir acompañada de numerosas especializaciones de si fisiología y esto constituye un campo prometedor para futuras investigaciones", dice Frank Glaw. "Pero lo más urgente es centrar los esfuerzos en la conservación de estas y otras especies microendémicas en Madagascar, que están fuertemente amenazadas por la deforestación."

sábado, 11 de febrero de 2012

El porqué de las rayas en las cebras

Las cebras desarrollaron sus características franjas blancas y negras para mantener alejadas a las moscas, según un estudio que recoge la revista científica británica 'Journal of Experimental Biology'.

Un equipo de científicos suecos y húngaros descubrió que la piel rayada de las cebras resulta "poco atractiva" para los tábanos por la forma en que refleja la luz, lo que podría ayudar a despejar un enigma que ha perseguido a los biólogos durante décadas.

"Comenzamos estudiando caballos negros, marrones y blancos, y descubrimos que obteníamos luz polarizada horizontalmente de los de piel oscura, un efecto muy atractivo para las moscas", explicó la profesora Susanne Akesson, de la Universidad de Lund (Suecia), según informa la BBC.

Sin embargo, en el caso de los caballos blancos, los científicos obtuvieron luz no polarizada, que se propaga a lo largo de cualquier tipo de plano, lo que la convierte en mucho menos atractiva para las moscas y tábanos que, como resultado, molestan menos.

Tras este hallazgo, el equipo se centró en investigar el tipo de luz que reflejaba la piel rayada de las cebras y cuál era la reacción de las moscas. Así, estudiaron el comportamiento de los tábanos ante distintas pizarras de colores claros y oscuros y otras sobre las que habían pintado franjas blancas y negras de distintas dimensiones.

Los científicos descubrieron que la pizarra con las franjas más estrechas, la que más se parecía al tipo de piel de las cebras, fue la que menos moscas atrajo, resultado que también obtuvieron al repetir la prueba sobre réplicas de caballos en tres dimensiones.

"Concluimos que las cebras habían evolucionado hasta alcanzar un diseño en el que las rayas fueran lo suficientemente estrechas para generar la menor atracción posible en los tábanos", añadió Akesson.

Un equipo de científicos suecos y húngaros descubrió que la piel rayada de las cebras resulta "poco atractiva" para los tábanos por la forma en que refleja la luz, lo que podría ayudar a despejar un enigma que ha perseguido a los biólogos durante décadas.

"Comenzamos estudiando caballos negros, marrones y blancos, y descubrimos que obteníamos luz polarizada horizontalmente de los de piel oscura, un efecto muy atractivo para las moscas", explicó la profesora Susanne Akesson, de la Universidad de Lund (Suecia), según informa la BBC.

Experimento con pizarras de colores

La luz rebota sobre la piel de los caballos oscuros y viaja en forma de ondas hasta los ojos de un tábano hambriento, en un plano horizontal, un tipo de movimiento muy llamativo para estos insectos, según Akesson.Sin embargo, en el caso de los caballos blancos, los científicos obtuvieron luz no polarizada, que se propaga a lo largo de cualquier tipo de plano, lo que la convierte en mucho menos atractiva para las moscas y tábanos que, como resultado, molestan menos.

Tras este hallazgo, el equipo se centró en investigar el tipo de luz que reflejaba la piel rayada de las cebras y cuál era la reacción de las moscas. Así, estudiaron el comportamiento de los tábanos ante distintas pizarras de colores claros y oscuros y otras sobre las que habían pintado franjas blancas y negras de distintas dimensiones.

Los científicos descubrieron que la pizarra con las franjas más estrechas, la que más se parecía al tipo de piel de las cebras, fue la que menos moscas atrajo, resultado que también obtuvieron al repetir la prueba sobre réplicas de caballos en tres dimensiones.

"Concluimos que las cebras habían evolucionado hasta alcanzar un diseño en el que las rayas fueran lo suficientemente estrechas para generar la menor atracción posible en los tábanos", añadió Akesson.

¿Y si la tierra fuese atravesada por un agujero negro?

De esta forma, los más pequeños ya se habrán evaporado y desaparecido hoy, casi 14.000 millones de años después del nacimiento del universo. En cambio, cabe la posibilidad de que aquellos agujeros negros que hayan superado una masa crítica mínima, de unos 500.000 millones de kilogramos, todavía se encuentren entre nosotros, quizá vagando por el espacio.

¿Podrían colisionar con la Tierra y atravesarla de lado a lado? ¿Cómo nos daríamos cuenta de que algo así ha ocurrido o está ocurriendo? Al fin y al cabo, un agujero negro de 500 millones de toneladas no es mayor de una billonésima de centímetro.

Prueba de resistencia en pianolas

Esta pieza para pianola, llamada “Galope circense” o también “Vals de la muerte” es imposible de interpretar para un humano, de hecho si existe es sólo porque a alguien, probablemente operario en una fábrica de pianolas, se le ocurrió fabricar un test de resistencia para los aparatos recién construidos. Si el instrumento no saltaba por los aires interpretando esto, entonces estaba preparado para salir a la venta.

Prohibiciones contra alimentos

Los humanos, aunque biológicamente pueden comer una gran variedad de alimentos, descartan algunos de ellos sistemáticamente de su dieta. Y si fisiológicamente podríamos ingerir y digerir estos alimentos, pero no lo hacemos, debe haber motivos culturales detrás de ello. ¿Pero como se han forjado esas tradiciones alimentarias ligadas a la cultura de cada pueblo? ¿Por qué comen lo que comen, y evitan lo que evitan las diferentes culturas que conviven en el mundo? ¿Por qué en España nos encanta la carne de cerdo y sus derivados, y los países islámicos la detestan? ¿Por qué el cerdo y no otro animal?

Según esta teoría lo que está claro es que debe haber una explicación práctica que explique que a día de hoy los musulmanes no puedan ni ver el cerdo. Es más, probablemente esta aversión radique en una serie de situaciones vividas en el pasado por los pueblos musulmanes y que tuviera mucho sentido en ese momento.

Si ahora se sigue sin comer cerdo es simplemente para seguir la tradición, no porque todavía se sigan cumpliendo los factores que los llevaron a descartar el cerdo de la dieta en su día.

A priori, la antipatía hacia la carne de cerdo es totalmente infundada e irracional. El cerdo es el animal doméstico que mayor capacidad tiene para transformar las plantas que come en carne de manera rápida y eficaz. A lo largo de su vida, un cerdo puede convertir el 35% de la energía de su pienso en carne, en comparación al 13% de los ovinos o el escaso 6,5% de los bovinos.

Además, las cerdas en tan sólo cuatro meses de gestación son capaces de parir ocho o más lechones, los cuales podrán llegar a pesar más de 200 kilos en sólo seis meses.

Queda patente que el cerdo es un animal muy económico y eficiente, lo que todavía hace que resulte más desconcertante que el Islam haya prohibido la ingestión de cerdo. Pero no sólo eso. No es que sólo no puedan comer carne de cerdo, sino que sienten una gran repugnancia hacia este animal, y según el Corán, sólo el hecho de tocarlo convertirá a la persona en inmunda.

Los propios musulmanes fundamentan esta aversión con una sencilla explicación: el cerdo es un animal sucio que se revuelca en barro y se come las heces, y por lo tanto, son un gran problema para la higiene y la salud pública. Sin embargo, estos hábitos del cerdo son culpa de sus dueños: si el cerdo tuviera agua limpia, no se revolcaría en barro, y si tuviera comida, no se comerían las heces. Además, esta explicación no es del todo coherente, pues hay muchos otros animales, que al igual que el cerdo, en algunas situaciones comen heces, como las gallinas, cabras, y perros, y no por ello son objeto de asco entre los fieles. Otra explicación que dan es que el cerdo es insalubre ya que puede transmitir triquinosis, lo que no es falso, pero no explica en ningún caso la aversión al cerdo por diferentes motivos. El primero es que la triquinosis no se conoció hasta hace relativamente poco, por lo que es imposible que conocieran este hecho hace cientos de años. Otro es que la triquinosis sólo se transmite por carne de cerdo no sometida a un tratamiento térmico adecuado, por lo tanto la solución hubiera sido fácil: cocinar correctamente el cerdo. Y por último, hay que decir que el cerdo no es ni mucho menos el único animal capaz de transmitir enfermedades a los humanos.

Hasta aquí podemos concluir que no fueron factores ligados a la deficiente higiene del cerdo, ni a su salubridad, los que fundamentaron esta costumbre hace miles de años.

Parece ser que la explicación radica en una frase escrita en el Levítico (libro sagrado): “Todo animal de casco partido y pezuñas hundidas y que rumia, lo comeréis”. Y por tanto, al ser el cerdo un animal que divide la pezuña, pero que no rumia, queda fuera de lugar y eso lo hace abominable. Parece ser pues, que el motivo primario que instiga este asco hacia el cerdo es que no es un animal rumiante. Nos tendremos que preguntar pues por qué los rumiantes son los únicos animales bien vistos por los escritos musulmanes.

La característica primordial que hizo que en el antiguo oriente medio se criaran animales rumiantes es que son capaces de ingerir únicamente vegetales ricos en celulosa. De esta manera los antiguos podrían obtener carne y leche sin tener que “compartir” parte de sus alimentos con el ganado. Mientras que vacas, cabras y ovejas sólo necesitan de algún lugar con plantas para alimentarse, el cerdo necesitaría algo más para comer si quieren ganar peso, y por tanto, sus dueños le deberían dar parte de su cosecha. Además los rumiantes también eran fuente de estiércol por los campos, fuerza de tracción y proporcionaban vestimentas. Estos razonamientos parecen tener cierta lógica y empiezan a dar sentido a que los cerdos fueran mal vistos en la antigüedad.

Además de los temas nutricionales, los cerdos no estaban bien adaptados al clima del antiguo Oriente Medio. Mientras que los rumiantes pueden vivir largos periodos sin agua, son capaces de termoregularse a través de la respiración y tienen un pelaje que los protege del sol, a los cerdos les faltan estas estrategias evolutivas. Por lo tanto, criar cerdos en ambientes áridos era mucho más caro que criar rumiantes, ya que a los primeros les debía suministrar sombra y refrescar periódicamente. También se le debe sumar que los cerdos no tiran de arados, no dan buenas fibras para hacer tejidos y tampoco dan leche, por lo tanto su única función era suministrar carne. Debido a todos estos motivos parece fácil de comprender que los pastores nómadas de Oriente medio no pudieran, ni quisieran cargar con cerdos si eran tan difíciles de mantener y ofrecían tan poco. Es posible que esta experiencia histórica fuera el origen de la aversión de estos pueblos hacia el cerdo.

Es posible que una visión antropológica pueda esclarecer estos interrogantes. A continuación haremos un breve repaso a una teoría antropológica que intenta explicar esta, a priori, incomprensible conducta.

Según esta teoría lo que está claro es que debe haber una explicación práctica que explique que a día de hoy los musulmanes no puedan ni ver el cerdo. Es más, probablemente esta aversión radique en una serie de situaciones vividas en el pasado por los pueblos musulmanes y que tuviera mucho sentido en ese momento.

Si ahora se sigue sin comer cerdo es simplemente para seguir la tradición, no porque todavía se sigan cumpliendo los factores que los llevaron a descartar el cerdo de la dieta en su día.

A priori, la antipatía hacia la carne de cerdo es totalmente infundada e irracional. El cerdo es el animal doméstico que mayor capacidad tiene para transformar las plantas que come en carne de manera rápida y eficaz. A lo largo de su vida, un cerdo puede convertir el 35% de la energía de su pienso en carne, en comparación al 13% de los ovinos o el escaso 6,5% de los bovinos.

Además, las cerdas en tan sólo cuatro meses de gestación son capaces de parir ocho o más lechones, los cuales podrán llegar a pesar más de 200 kilos en sólo seis meses.

Queda patente que el cerdo es un animal muy económico y eficiente, lo que todavía hace que resulte más desconcertante que el Islam haya prohibido la ingestión de cerdo. Pero no sólo eso. No es que sólo no puedan comer carne de cerdo, sino que sienten una gran repugnancia hacia este animal, y según el Corán, sólo el hecho de tocarlo convertirá a la persona en inmunda.

Los propios musulmanes fundamentan esta aversión con una sencilla explicación: el cerdo es un animal sucio que se revuelca en barro y se come las heces, y por lo tanto, son un gran problema para la higiene y la salud pública. Sin embargo, estos hábitos del cerdo son culpa de sus dueños: si el cerdo tuviera agua limpia, no se revolcaría en barro, y si tuviera comida, no se comerían las heces. Además, esta explicación no es del todo coherente, pues hay muchos otros animales, que al igual que el cerdo, en algunas situaciones comen heces, como las gallinas, cabras, y perros, y no por ello son objeto de asco entre los fieles. Otra explicación que dan es que el cerdo es insalubre ya que puede transmitir triquinosis, lo que no es falso, pero no explica en ningún caso la aversión al cerdo por diferentes motivos. El primero es que la triquinosis no se conoció hasta hace relativamente poco, por lo que es imposible que conocieran este hecho hace cientos de años. Otro es que la triquinosis sólo se transmite por carne de cerdo no sometida a un tratamiento térmico adecuado, por lo tanto la solución hubiera sido fácil: cocinar correctamente el cerdo. Y por último, hay que decir que el cerdo no es ni mucho menos el único animal capaz de transmitir enfermedades a los humanos.

Hasta aquí podemos concluir que no fueron factores ligados a la deficiente higiene del cerdo, ni a su salubridad, los que fundamentaron esta costumbre hace miles de años.

Parece ser que la explicación radica en una frase escrita en el Levítico (libro sagrado): “Todo animal de casco partido y pezuñas hundidas y que rumia, lo comeréis”. Y por tanto, al ser el cerdo un animal que divide la pezuña, pero que no rumia, queda fuera de lugar y eso lo hace abominable. Parece ser pues, que el motivo primario que instiga este asco hacia el cerdo es que no es un animal rumiante. Nos tendremos que preguntar pues por qué los rumiantes son los únicos animales bien vistos por los escritos musulmanes.

La característica primordial que hizo que en el antiguo oriente medio se criaran animales rumiantes es que son capaces de ingerir únicamente vegetales ricos en celulosa. De esta manera los antiguos podrían obtener carne y leche sin tener que “compartir” parte de sus alimentos con el ganado. Mientras que vacas, cabras y ovejas sólo necesitan de algún lugar con plantas para alimentarse, el cerdo necesitaría algo más para comer si quieren ganar peso, y por tanto, sus dueños le deberían dar parte de su cosecha. Además los rumiantes también eran fuente de estiércol por los campos, fuerza de tracción y proporcionaban vestimentas. Estos razonamientos parecen tener cierta lógica y empiezan a dar sentido a que los cerdos fueran mal vistos en la antigüedad.

Además de los temas nutricionales, los cerdos no estaban bien adaptados al clima del antiguo Oriente Medio. Mientras que los rumiantes pueden vivir largos periodos sin agua, son capaces de termoregularse a través de la respiración y tienen un pelaje que los protege del sol, a los cerdos les faltan estas estrategias evolutivas. Por lo tanto, criar cerdos en ambientes áridos era mucho más caro que criar rumiantes, ya que a los primeros les debía suministrar sombra y refrescar periódicamente. También se le debe sumar que los cerdos no tiran de arados, no dan buenas fibras para hacer tejidos y tampoco dan leche, por lo tanto su única función era suministrar carne. Debido a todos estos motivos parece fácil de comprender que los pastores nómadas de Oriente medio no pudieran, ni quisieran cargar con cerdos si eran tan difíciles de mantener y ofrecían tan poco. Es posible que esta experiencia histórica fuera el origen de la aversión de estos pueblos hacia el cerdo.

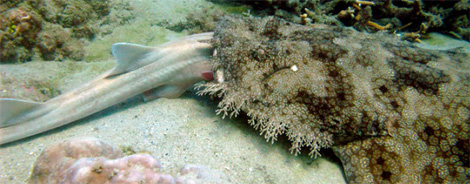

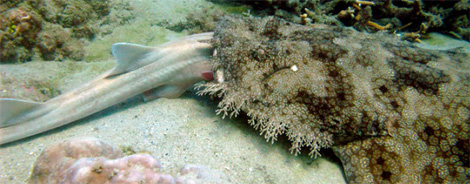

El tiburón canibal

Los llamados tiburones alfombra son 12 especies de la familia de los orectolóbidos ('Orectolobidae') que depredan invertebrados, cefalópodos (pulpos, calamares, etc.) y algunos peces en los fondos marinos acecándolos ocultos bajo sus efectivos camuflajes.

Pero los investigadores expertos en este tipo de grandes peces cartilaginosos saben desde 2007 que, de forma ocasional, también devoran a otros tiburones.

Las observaciones sobre el terreno de eventos de depredación en los arrecifes de coral son muy raros. De manera que los científicos suelen usar el contenido estomacal de los animales para determinar su dieta y su lugar dentro de la cadena alimenticia marina.

Las observaciones sobre el terreno de eventos de depredación en los arrecifes de coral son muy raros. De manera que los científicos suelen usar el contenido estomacal de los animales para determinar su dieta y su lugar dentro de la cadena alimenticia marina.

Sin embargo, el pasado día 1 de agosto de 2011, mientras llevaban a cabo un censo visual submarino de la fauna del arrecife coralino de la isla Gran Keppel, perteneciente a la Gran Barrera Coralina australiana, los miembros de un grupo científico encontraron un tiburón alfombra ('Eucrossorhinus dasypogon') de un metro y 25 centímetros con la cabeza de un tiburón bambú de la especie 'Chiloscyllium punctatum' y de un metro de longitud completamente dentro de la boca.

Los investigadores estuvieron observando la escena durante media hora en la que tomaron las imágenes. Y en ese tiempo ninguno de los animales se movió apenas. Los científicos creen que devorar completemente al tiburón bambú le podría llevar al tiburón alfombra varias horas.

Pero los investigadores expertos en este tipo de grandes peces cartilaginosos saben desde 2007 que, de forma ocasional, también devoran a otros tiburones.

Sin embargo, el pasado día 1 de agosto de 2011, mientras llevaban a cabo un censo visual submarino de la fauna del arrecife coralino de la isla Gran Keppel, perteneciente a la Gran Barrera Coralina australiana, los miembros de un grupo científico encontraron un tiburón alfombra ('Eucrossorhinus dasypogon') de un metro y 25 centímetros con la cabeza de un tiburón bambú de la especie 'Chiloscyllium punctatum' y de un metro de longitud completamente dentro de la boca.

Los investigadores estuvieron observando la escena durante media hora en la que tomaron las imágenes. Y en ese tiempo ninguno de los animales se movió apenas. Los científicos creen que devorar completemente al tiburón bambú le podría llevar al tiburón alfombra varias horas.

El vidrio común puede ser un buen conductor eléctrico

¿Qué se ve en el video?

En este experimento se muestra como el vidrio (inicialmente, es un aislante eléctrico) se convierte en un buen conductor con la ayuda de la intensa llama de un soplete.

Primero, las dos bases de cerámica (sockets) están cableadas en serie a la corriente eléctrica de una casa. Cuando las dos bombillas incandescentes (del mismo voltaje) se colocan en las bases y se conecta la electricidad, por ambos focos atraviesa la misma cantidad de corriente, por lo cual se encienden con la misma intensidad.

Después, uno de los focos se retira de la base, el circuito se rompe y la otra bombilla deja de iluminar. Si remplazamos la bombilla por un material conductor (un cable metálico, por ejemplo), el circuito una vez más se completa y la bombilla se enciende. En este caso es un pedazo de vidrio que ayudado por una flama intensa eleva su temperatura; y vemos como se enciende el otro foco.

¿Por qué pasa esto?

Cuando elevamos la temperatura del vidrio, algunos de los electrones del material adquirirán tanta energía que podrán hacer transiciones donde el resultado es la emisión de luz (de color rojo, para este caso). En tal estado de excitación (como dicen los físicos), los electrones están poco unidos al núcleo atómico, tal como un metal. Tanto así que pueden desplazarse fácilmente por el material, por lo cual pueden ser parte de una corriente eléctrica, entonces se dice que estos electrones están deslocalizados cuánticamente, y el material es conductor.

¿Cuál es la clave y aplicaciones del experimento?

La obtención de electrones deslocalizados es la pieza fundamental de esta idea. Estos electrones están presentes en los metales, pero también en materiales a altas temperaturas; por ejemplo, plasmas: estrellas, gases de bulbos-neon encendidos, entre otros. Más aún, también están presentes en moléculas orgánicas; anillos de benceno, por mencionar un notable representante.

Efectivamente, se pueden manufacturar estructura plásticas capaces de conducir electricidad o manipular luz o ambas. De este modo, como muestran algunos diseños de producto, es factible la fabricación de circuitos en tabletas flexibles donde se puede generar, transmitir y almacenar información con el formato de electrones o fotones.

¿Quién investiga este tema?

De hecho en el Laboratorio de Óptica no-lineal de CCADET-UNAM, trabajamos en esta línea de investigación de optoelectrónica. Pues, a temperatura ambiente, insertamos polímeros en matrices de vidrio puro. Estos prototipos son capaces de conducir electricidad y exhibir fenómenos ópticos diversos por lo cual pueden llegar a ser parte de un dispositivo de alta tecnología. Pero, esa es otra historia, que les platicaremos en otro post. Por lo pronto, si están interesados en esta clase de investigaciones, pueden consultar algunos posts sobre nuestros artículos más recientes con moléculas dipolares y octupolares.

miércoles, 8 de febrero de 2012

Nuevo riesgo en Fukushima

El riesgo sísmico en la planta nuclear de Fukushima ha aumentado después del terremoto de magnitud 9 que afectó a Japón el pasado mes de marzo. Un nuevo estudio, publicado en la revista de la Unión Europea de Geociencias (EGU, por sus siglas en inglés) 'Solid Earth', y que ha utilizado datos de más de 6.000 terremotos, demuestra que el temblor de 11 de marzo ha reactivado una falla sísmica cerca de la central nuclear.

La investigación sugiere que las autoridades japonesas deben reforzar la seguridad de la central nuclear de Fukushima para que pueda soportar terremotos de gran tamaño que puedan suponer una nueva amenaza directa para la región. La prefectura en la que se encuentra la planta fue testigo de uno de los peores desastres nucleares de la historia después de haber sido arrasada por un terremoto de magnitud 9 y un tsunami con olas de hasta 30 metros.

El epicentro del seísmo que azotó Japón el 11 de marzo de 2011 estaba en el fondo del mar a unos 160 km de la costa de Fukushima. Los autores del trabajo, pertenecientes a universidades de Japón Y China, concluyen que podría ocurrir en el futuro uno mucho más cercano a la costa en la que se encuentra la central de Fukushima.

La posibilidad de un nuevo gran terremoto

"Hay algunas fallas activas en el área de la central nuclear y nuestros resultados muestran la existencia de anomalías estructurales parecidas bajo las zonas de Iwaki y la de Fukushima. Teniendo en cuenta que hubo recientemente un gran terremoto en Iwaki, creemos que es posible que pueda ocurrir en esta zona un seísmo de fuerza similar al de Fukushima", dice el director de la investigación Dapeng Zhao, profesor de geofísica de la universidad japonesa de Tohoku.El 11 de abril de 2011, un terremoto de magnitud 7 en Iwaki se convertía en la réplica más potente del terremoto del 11 de marzo y su epicentro estuvo tierra adentro. Ocurrió 60 km al suroeste de la central nuclear de Fukushima.

La investigación demuestra que el terremoto de Iwaki fue provocado por los fluidos en movimiento ascendente desde la zona de subducción de la placa del Pacífico hacia la corteza terrestre. La placa del Pacífico se mueve bajo el noreste Japón, lo que aumenta la temperatura y la presión de la roca en ella. Esto conduce a la eliminación del agua de los minerales, generando fluidos que son menos densos que la roca circundante. Estos fluidos se mueven hasta la corteza superior y pueden alterar las fallas sísmicas.

"Los líquidos ascendentes pueden reducir la fricción de una parte de una falla activa por lo que pueden apretar el gatillo para causar un terremoto de gran magnitud. Esto, junto con las variaciones de tensión causadas por el evento del 11 de marzo, es lo que causó el temblor de Iwaki", dice Ping Tong, autor principal del artículo.

lunes, 6 de febrero de 2012

La primera calada

'Será una cuestión de genes'. Era una de la hipótesis que podía explicar la razón por la que después de dar las primeras caladas a un cigarrillo, algunos se quedaran con ganas de más y otros se quedaran impasibles. Ahora, un nuevo estudio realizado por investigadores españoles confirma la influencia de la genética no sólo en el hábito de fumar sino en la cantidad de cigarrillos que se consumen.

Aunque en esta adicción intervienen múltiples factores, como los psicosociales, dado que el papel de la genética influye en un 50%, los autores de este trabajo, de la Universidad Europea de Madrid, han analizado 17 variantes genéticas implicadas en este hábito y han identificado una serie de genes que contribuyen al mayor consumo de tabaco.